helping to deliver secure software updates from code to the edge.

You have been redirected to the JFrog website

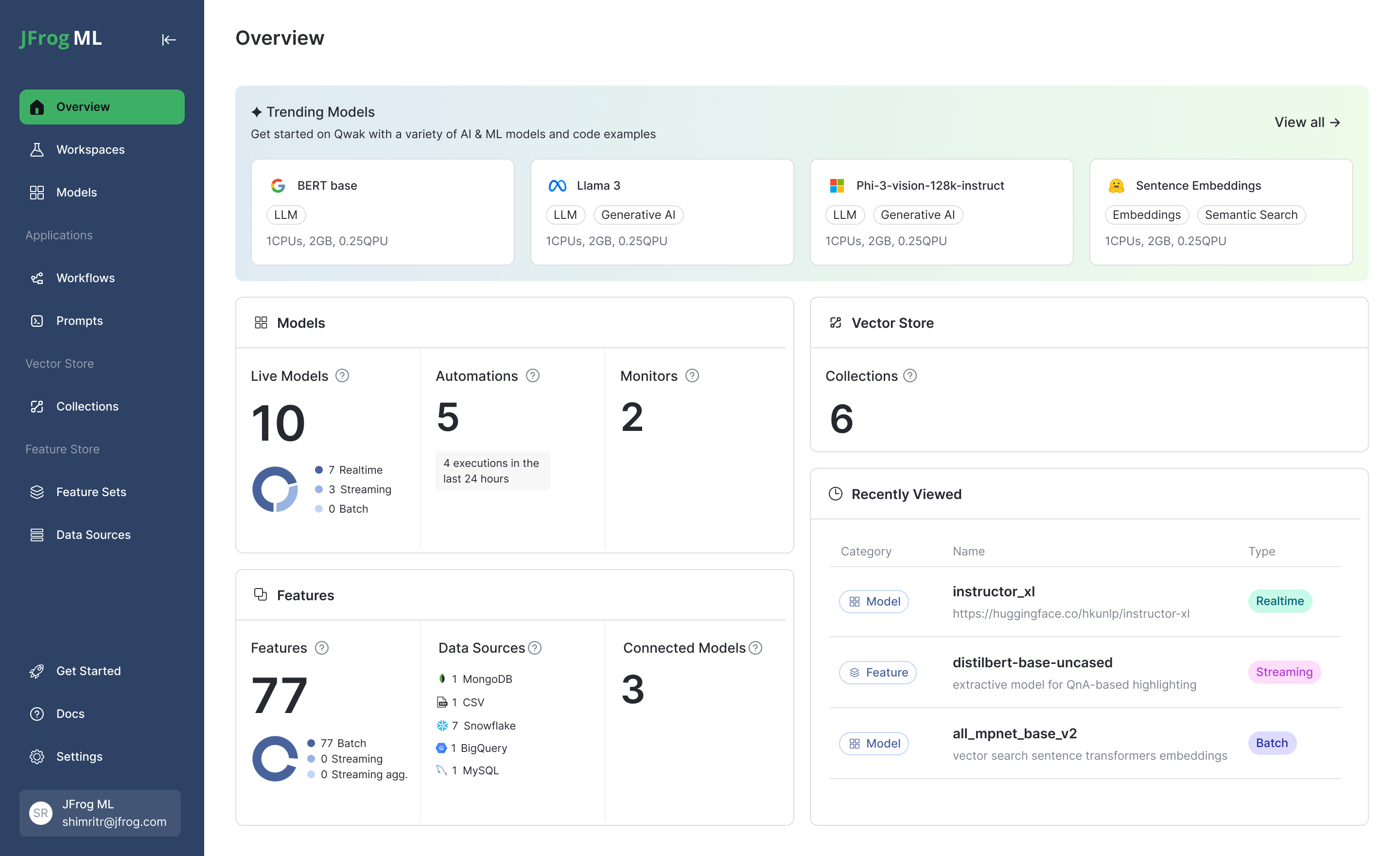

Bringen Sie verlässliche Modelle

schnell in die Produktion

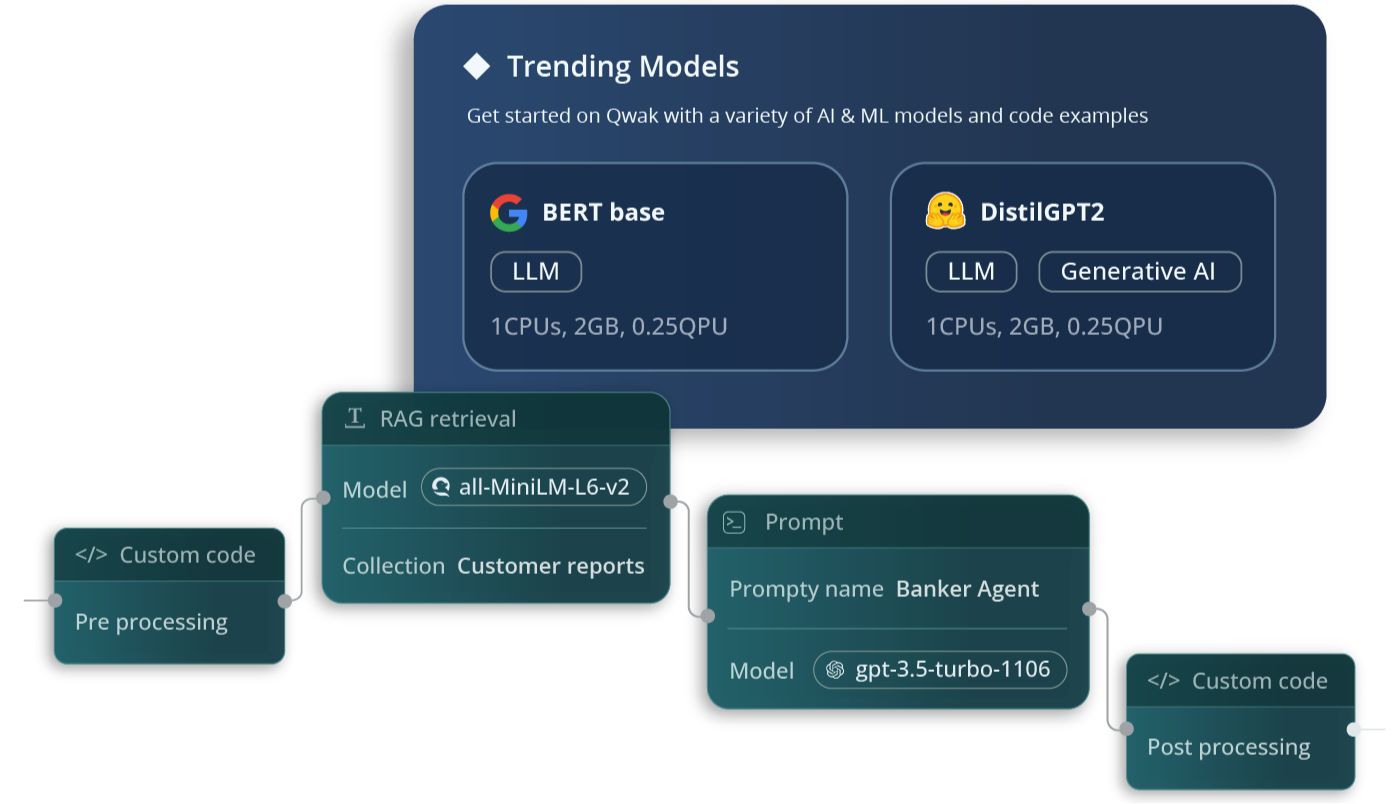

Für schnellere und erfolgreichere KI/ML Aktivitäten. Profitieren Sie von einem innovativen Ansatz zur KI-Entwicklung, der Modelle wie ein Pakete behandelt und so die Modellentwicklung, Modellbereitstellung und Modellverwaltung vereinfacht.

Jetzt Blogbeitrag lesen »