helping to deliver secure software updates from code to the edge.

You have been redirected to the JFrog website

werden.Read Less >

So verwenden Sie JFrog Artifactory mit Amazon SageMaker

Integration von JFrog Artifactory mit Amazon SageMaker

DevSecOps in der Ära der KI/ML-Modellentwicklung mit AWS

JFrog und AWS beschleunigen die Entwicklung von sicherem Machine Learning

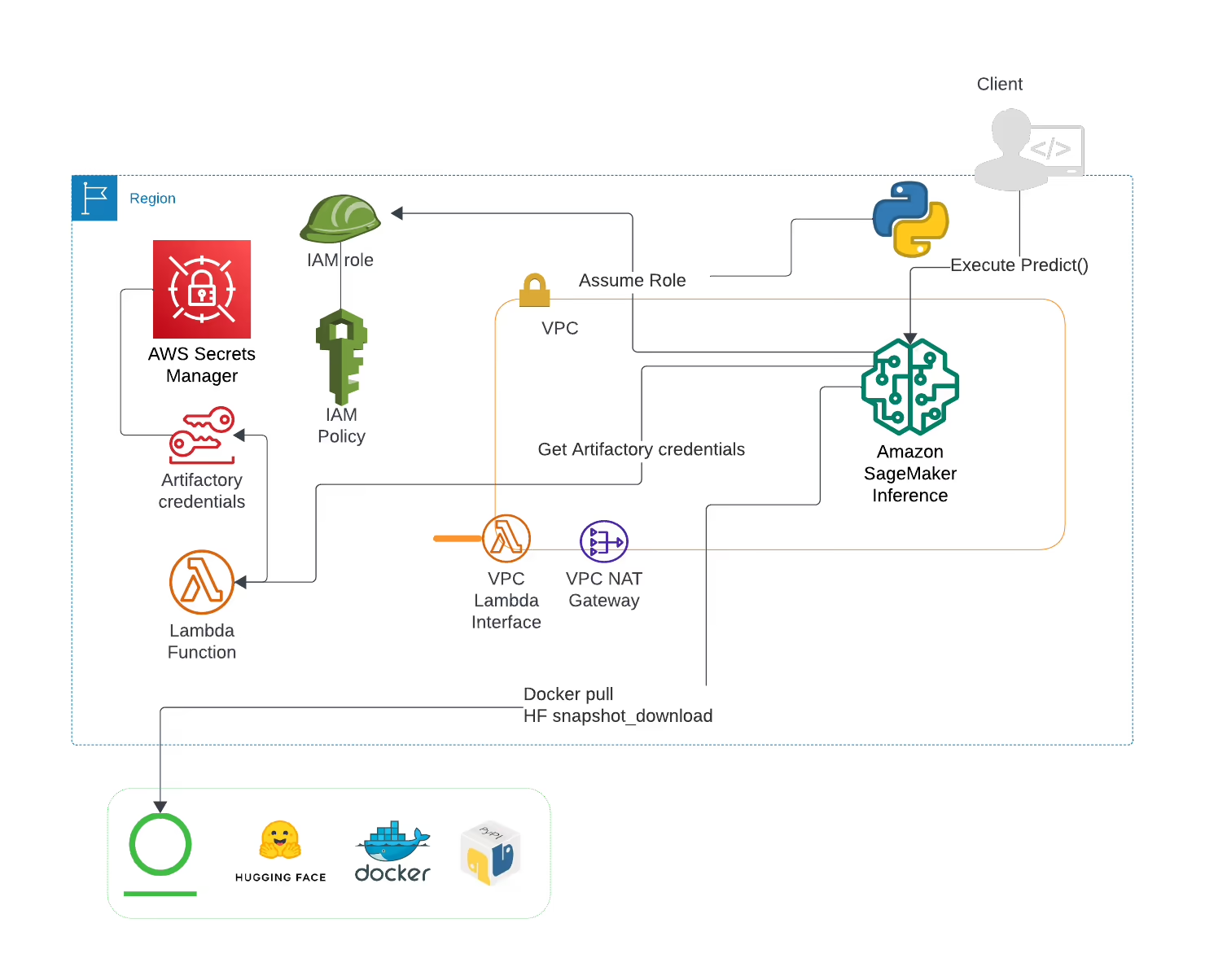

Die Integration von JFrog Artifactory mit Amazon SageMaker ermöglicht Ihnen die effiziente Verwaltung, Versionierung und Verteilung von Machine-Learning-Modellen, Datensätzen und anderen Artefakten. Diese Integration stellt sicher, dass Ihre ML-Workflows von der Schulung bis zur Bereitstellung gestrafft werden, während Sie die Kontrolle über alle Abhängigkeiten behalten und eine teamübergreifende Zusammenarbeit ermöglichen.

Um JFrog Artifactory für die Verwaltung von SageMaker-Artefakten einzurichten, müssen Sie Artifactory konfigurieren, um Ihre Machine Learning-Modelle, Datensätze und Docker-Images zu speichern. Diese Artefakte können dann in SageMaker für die Schulung und die Bereitstellung verwendet werden. Detaillierte Einrichtungsanweisungen finden Sie in der JFrog- und AWS-Dokumentation.

Ja, JFrog Xray kann Machine Learning-Modelle, Datensätze und Container-Images, die in Artifactory gespeichert sind, auf Sicherheitslücken und Compliance-Probleme scannen. Dadurch wird sichergestellt, dass nur sichere und konforme Artefakte in Amazon SageMaker bereitgestellt werden, wodurch die Sicherheit Ihrer ML-Workflows erhöht wird.

JFrog Artifactory bietet eine robuste Versionskontrolle für Machine Learning-Modelle und andere Artefakte. Jede Version eines Modells oder Datensatzes wird mit eindeutigen Metadaten gespeichert, so dass Sie Änderungen leicht nachverfolgen, auf frühere Versionen zurücksetzen und die Reproduzierbarkeit in Ihren SageMaker-Workflows sicherstellen können.

JFrog Artifactory kann eine Vielzahl von Artefakten für die Verwendung mit Amazon SageMaker verwalten, darunter Machine Learning-Modelle, Datasets, Jupyter-Notebooks, Docker-Images und Python-Pakete. Diese Flexibilität ermöglicht es Ihnen, die Verwaltung aller für Ihre ML-Projekte erforderlichen Ressourcen an einem Ort zu zentralisieren.