Shadow AI in 5 Schritten erkennen und eliminieren

Es gibt einen enormen Druck, KI in Arbeitsprozesse zu integrieren. Ihre Entwickler müssen schnell liefern, und sie finden Wege, die Arbeit zu erledigen. Aber dieser Innovationsdruck findet oft außerhalb etablierter Strukturen und Kontrollen statt und erzeugt ein weit verzweigtes, unsichtbares Risiko namens Shadow AI.

Um Ihr Unternehmen abzusichern, müssen Sie zunächst verstehen, was Shadow AI eigentlich ist.

Es ist nicht einfach nur ein Entwickler, der eine Datei auf seinen Laptop lädt. Shadow AI ist die Gesamtheit nicht gemanagter KI-Assets in Ihrer Supply Chain. Dazu gehören drei unterschiedliche, aber gleichermaßen riskante Komponenten:

- Externe API-Calls: Hardcodierte API Keys und Datenabfluss-Risiken durch Aufrufe an Third-Party-Services innerhalb Ihres Codes.

- Open-Source-Modelle: Verwundbarkeiten wie Supply-Chain-Poisoning durch Modelle, die aus öffentlichen Repositories heruntergeladen werden.

- Benutzerdefinierte Modelle: Proprietäre, intern entwickelte Modelle ohne Security-Scans oder auditierbare Herkunft.

Wenn Sie nicht alle Arten von KI-Ressourcen erkennen und verwalten, setzen Sie Ihr Unternehmen Risiken wie Datenlecks, böswilligen Eingriffen und Lizenzverstößen aus. Wir erklären Ihnen daher fünf konkrete Schritte, um sie mit dem JFrog AI Catalog unter Kontrolle zu bringen.

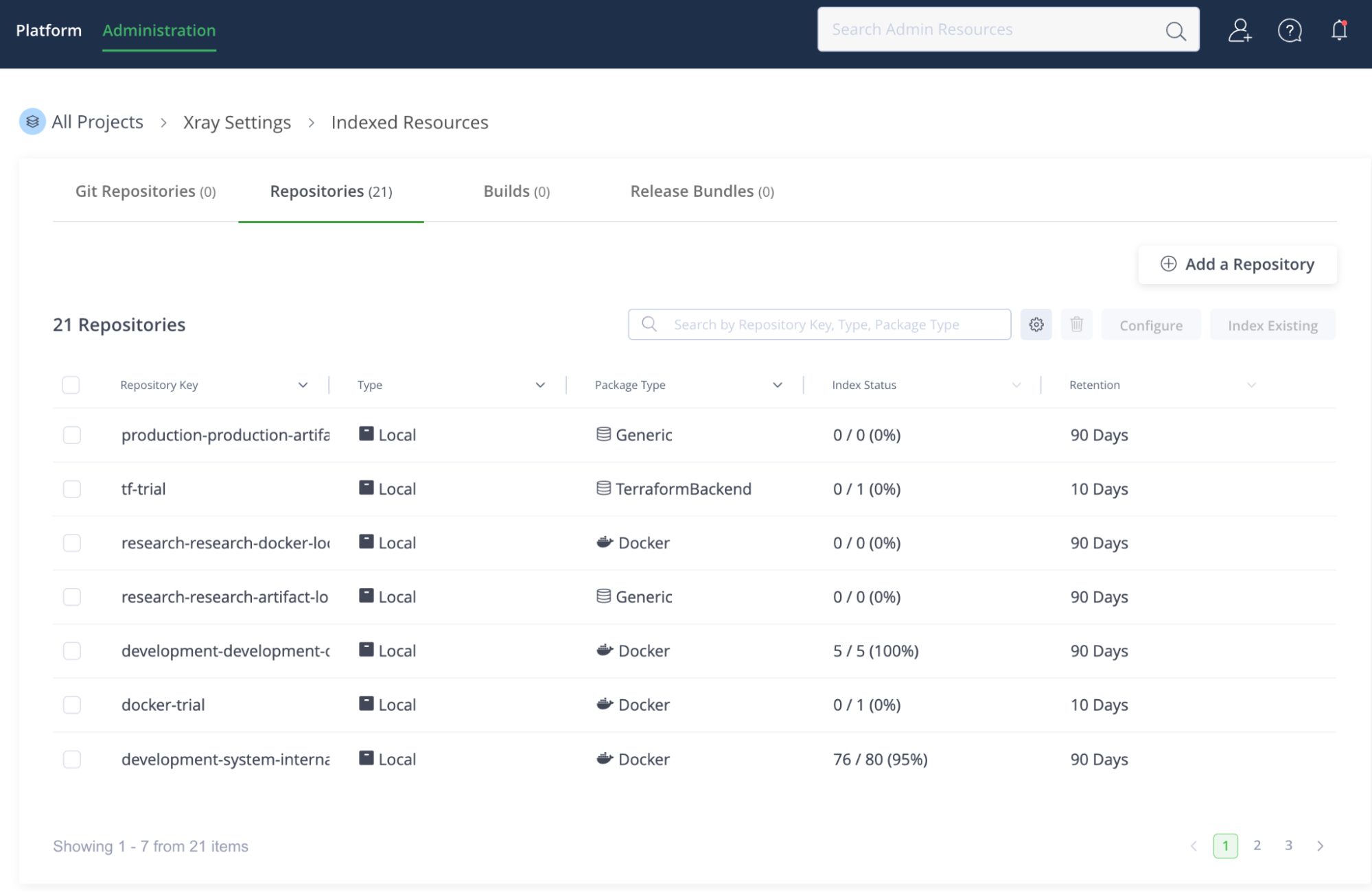

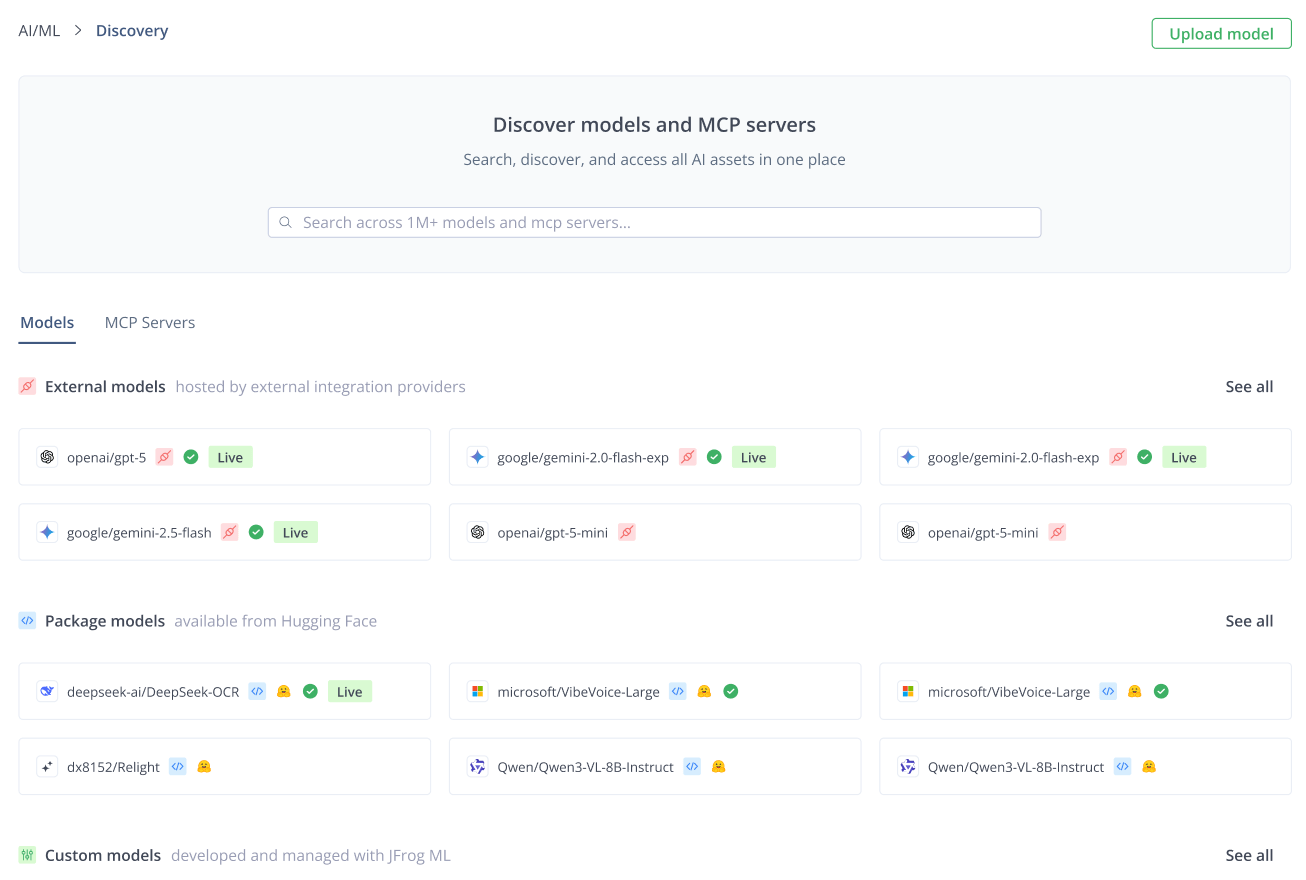

Schritt 1: Scannen Sie Ihre bestehenden Repositories

Der erste Schritt, um Shadow AI in den Griff zu bekommen ist: Hören Sie auf zu raten, fangen Sie an zu auditieren. Sie brauchen einen einheitlichen Mechanismus, der jedes Artefakt, jeden Build und jedes Source-Code-Repository in Ihrem System scannt, um KI-Nutzung zu erkennen – egal ob sie in einer Binärdatei steckt oder in einem API-Call.

Dieser Prozess nutzt die zugrunde liegenden Security-Komponenten von JFrog, um ungemanagte KI-Assets über die gesamte Plattform zu finden:

- JFrog Xray scannt Ihre Repositories und Artefakte (z. B. Docker-Images oder Maven-Packages), um jedes Custom- oder Open-Source-Modell, Package, Dataset bzw. jede zugehörige Abhängigkeit zu identifizieren.

- JFrog Advanced Security führt Source-Code-Analysen durch, um Signaturen von Aufrufen externer KI-APIs (z. B. OpenAI, Gemini oder Anthropic) zu erkennen.

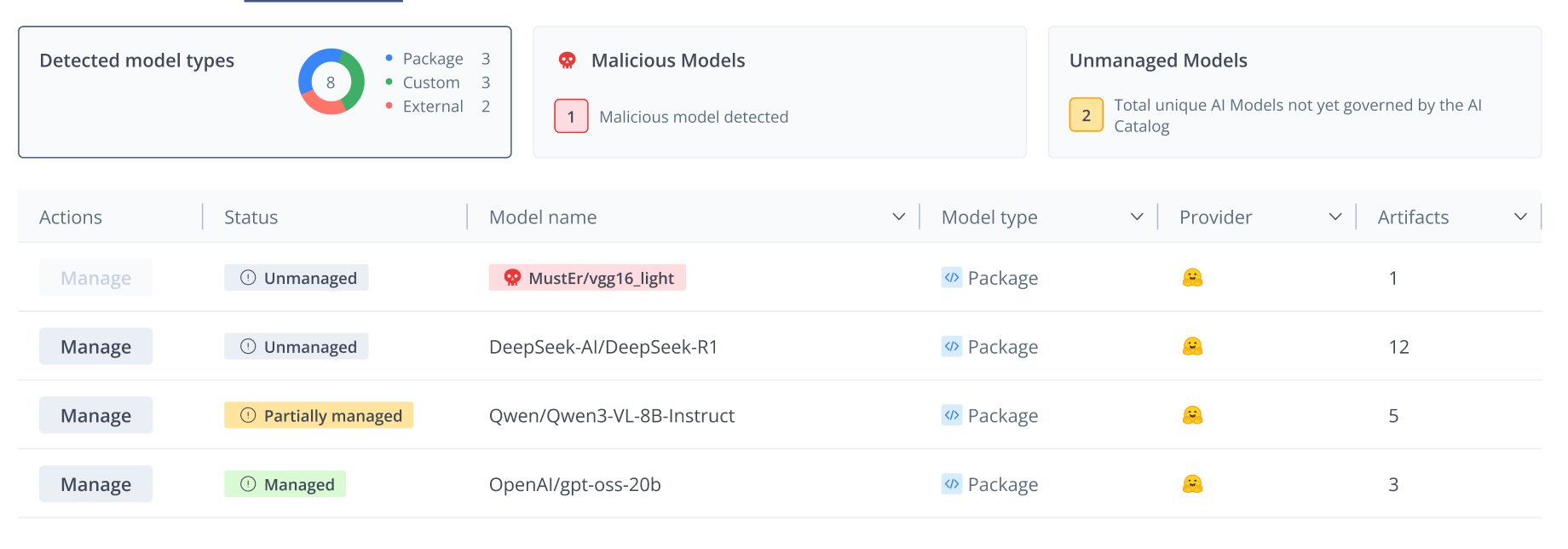

Nach Abschluss des Scans wird das Dashboard Detected Models im AI Catalog zu Ihrer zentralen Single Source of Truth und zeigt jede Instanz von KI-Nutzung – gemanagt oder nicht gemanagt – über all Ihre Repositories und Builds hinweg.

Schritt 2: Prüfen Sie das „Shadow“-Inventar

Jetzt, da Sie den vollständigen Überblick haben, müssen Sie Prioritäten setzen. Das Dashboard Detected Models sortiert und kategorisiert Funde automatisch, sodass Sie sich zuerst auf die risikoreichsten Assets konzentrieren können.

Priorisieren Sie Ihre Prüfung anhand dieser drei Kriterien:

- Bösartige Modelle zuerst: Gehen Sie Modelle, die von Xray als “malicious” oder “high risk” markiert sind, umgehend an. Das sind Ihre akuten Brandherde.

- Nutzungsfrequenz: Sortieren Sie Modelle nach ihrer Häufigkeit über Ihre Builds hinweg. Weit verbreitete Nutzung weist auf eine starke Abhängigkeit und ein höheres Betriebsrisiko hin, um das Sie sich schnell kümmern müssen.

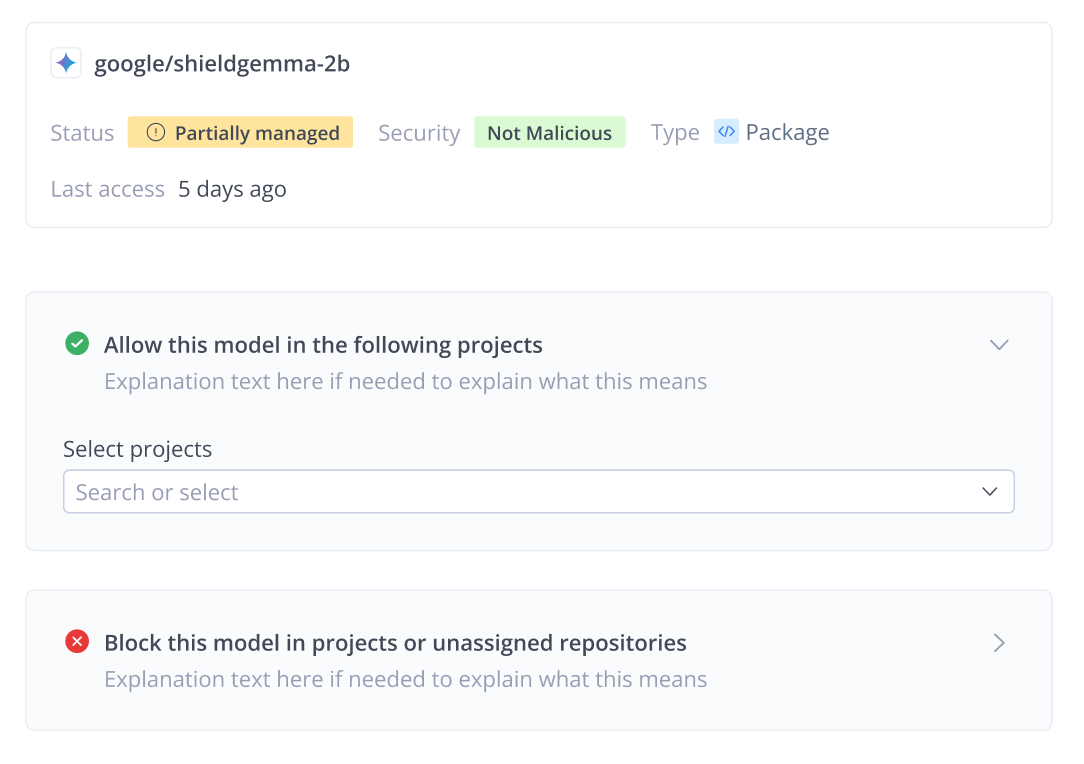

- Governance-Status: Das System markiert Assets als “unmanaged”, “managed” oder “partially managed”.

Dieses detaillierte Inventar erzwingt den Wechsel von reaktiver zu proaktiver Governance; Sie gehen über das bloße Identifizieren von Shadow AI hinaus und verstehen deren konkrete Auswirkungen auf Ihr Geschäft.

Schritt 3: Risiko bewerten

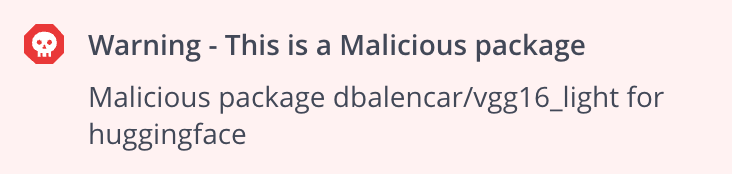

Bevor Sie ein Modell als „allow“ oder „block“ setzen, müssen Sie das Risiko quantifizieren. Dafür ist ein Deep Dive in die Security- und Compliance-Auswirkungen des nicht gemanagten Assets nötig.

1. Sicherheitsrisiko:

Open-Source-Modelle, insbesondere aus Hubs wie Hugging Face, sind Zielscheiben für Supply-Chain-Angriffe wie Namespace Hijacking. Angreifer können „vergiftete“ Modelle hochladen, die beim Download Code ausführen – bis hin zu Reverse-Shell-Injections und einer Kompromittierung des Systems.

2. Compliance-Risiko:

Nicht gemanagte Assets bergen auch erhebliche rechtliche Risiken. Lizenzseitig führt die unabsichtliche Nutzung eines Modells mit Non-Commercial-Lizenz in einem kommerziellen Produkt zu Verstößen gegen das IP-Recht. Außerdem schaffen hardcodierte API-Calls an Services wie OpenAI ein Data-Leakage-Risiko, bei dem sensible Prompts und proprietäre Daten Ihre kontrollierte Umgebung verlassen und von Third-Party-Systemen verarbeitet werden.

Um diesen Bedrohungen zu begegnen, nutzt AI Catalog JFrog Xray und Advanced Security, um für jedes Modell eine klare Sicherheits- und Compliance-Ansicht aufzubauen. Die Plattform scannt die Artefakte, die diese Modelle enthalten, auf Schwachstellen in Abhängigkeiten und markiert bösartige oder High-Risk-Packages, damit Sie schnell handeln können. Gleichzeitig prüft sie die Lizenz-Compliance und erkennt API-Signaturen in Ihrem Code. Durch die Aggregation dieser Security- und Legal-Daten in einer einzigen Ansicht erhalten Sie den auditierbaren Nachweis, der für eine eindeutige Governance-Entscheidung nötig ist.

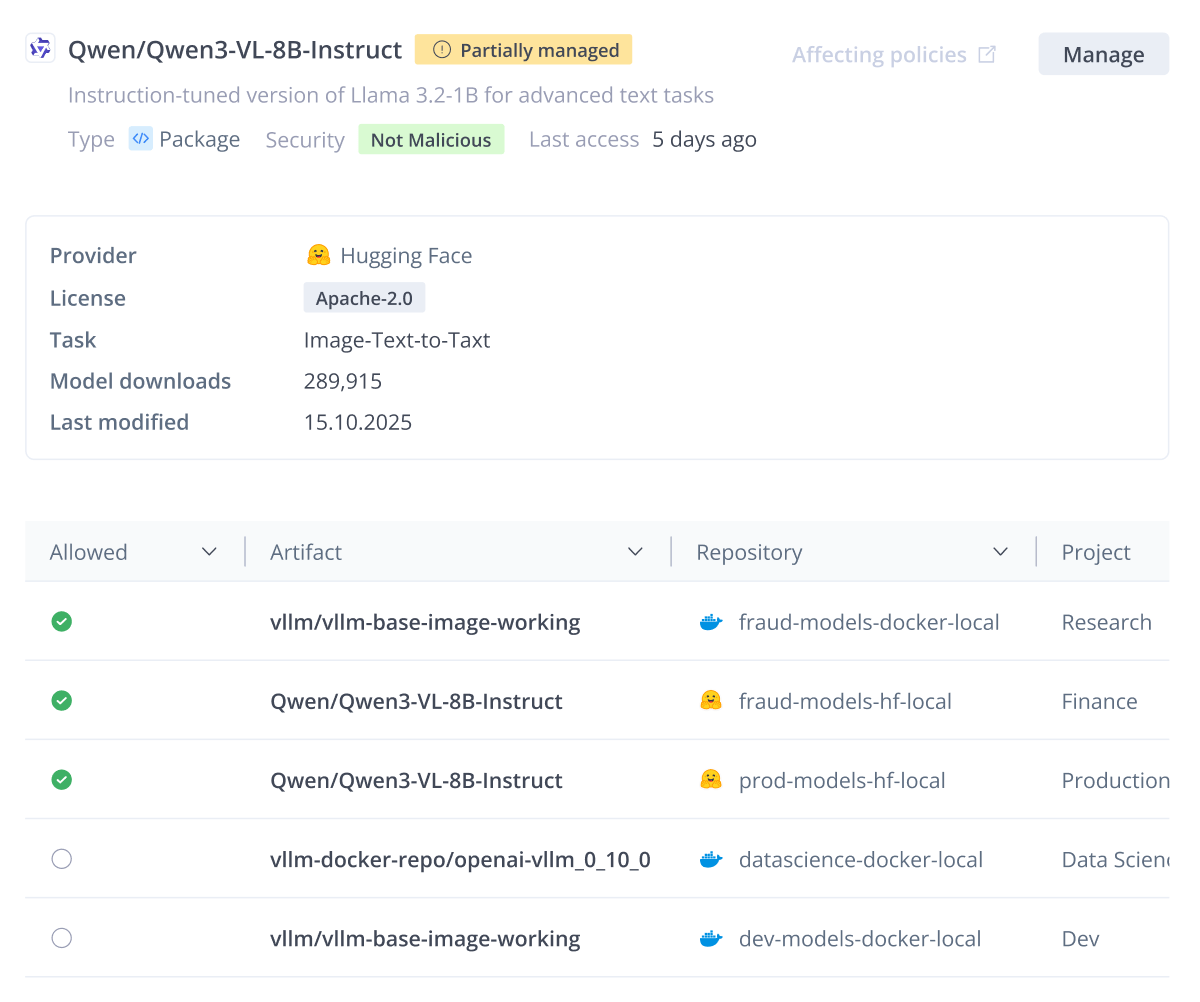

Schritt 4: Durchsetzung von Richtlinien

Mit einem quantifizierten Risiko wechseln Sie von passiver Beobachtung zu aktiver Kontrolle. Ihr Ziel ist einfach: Stellen Sie sicher, dass Teams nur konforme, freigegebene KI-Assets nutzen – und blocken Sie alles andere.

Ist ein Asset “high risk”, bösartig oder verstößt gegen eine Richtlinie, können Sie es sofort blockieren.

- Block from Cache: Wenn Sie ein Modell als „blocked“ markieren, erstellt das System automatisch eine Curation-Policy. In einem Schritt entfernt es alle gecachten Instanzen dieses Modells in Remote-Repositories und verhindert zukünftige Downloads.

- Xray Block-Richtlinie: Für lokale Repositories stellt eine Xray Download Block-Richtlinie sicher, dass das Modell in regulierten Projekten nicht verwendet werden kann.

Häufig stoßen Sie auf Modelle mit dem Status “partially managed”. Das weist auf einen inkonsistenten Zustand hin: Das Modell ist nur in einem Projekt zulässig, wird jedoch weiterhin in den Repositorys anderer Projekte erkannt, für die noch keine Governance-Entscheidung getroffen wurde.

Anstatt diese Modelle zu blockieren und valide Workflows potenziell zu unterbrechen, nutzen Sie die Aktion “allow”, um die Governance auf die nicht gemanagten Instanzen auszuweiten. Dadurch wird der Status des Modells vereinheitlicht und es wird in allen Teams, die es verwenden, konsistent überwacht und abgesichert.

Bestehende Nutzung managen

Manche Modelle sind bereits teamübergreifend im Einsatz, wodurch ein sofortiger, harter Block disruptiv wäre. Dafür ist der Status “partially managed” der Schlüssel:

- Dieser Status zeigt, dass das Modell in einem Projekt allowed ist, in einem anderen jedoch unmanaged bleibt – häufig aufgrund geteilter Repositories.

- Die Lösung besteht darin, die Aktion “allow” zu nutzen, um die verbleibenden nicht gemanagten Projekte unter die Governance des AI Catalog zu bringen – für einen reibungslosen Übergang in einen vollständig gemanagten Zustand, ohne unnötige Fehlerzustände für Entwickler zu verursachen.

Schritt 5: Den „Golden Path“ schaffen

Der letzte Schritt besteht darin, Ihre Entwicklererfahrung von einem „Wilden Westen“ nicht genehmigter Modelle auf einen „goldenen Pfad“ sicherer Innovation umzustellen.

Wenn Sie ein KI-Asset blocken, müssen Sie eine vertrauenswürdige Alternative bereitstellen. Der AI Catalog ermöglicht das durch einen zentralen Self-Service-Hub:

- Trusted Discovery: Developer durchsuchen das Registry nach freigegebenen internen, Open-Source- und kommerziellen Services. Sie wissen sofort, dass jedes gewählte Asset sicher und konform ist.

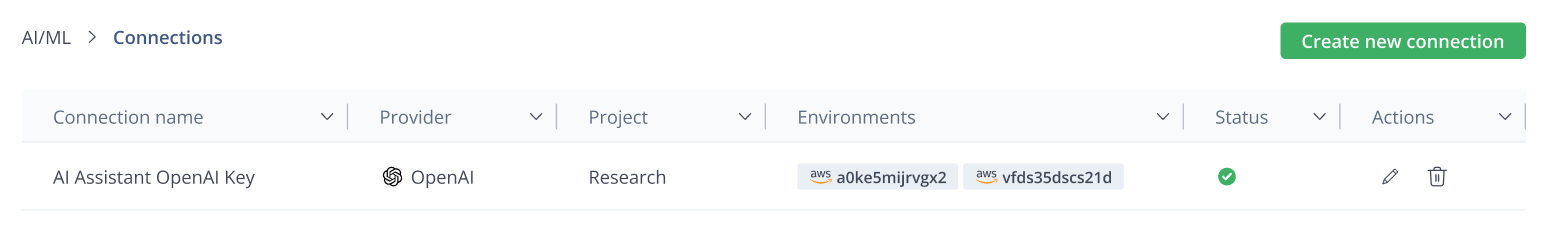

- Credential Abstraction: Das AI Gateway löst das „API-Key“-Problem. Es abstrahiert das Credential-Management, sodass Entwickler niemals mit rohen API-Keys hantieren. Sie verbinden sich einfach mit dem regulierten Dienst.

Indem Sie Ihr Governance-Dashboard in eine einzige Steuerungsebene verwandeln, verwandeln Sie Ihre KI-Strategie von unkontrolliertem Chaos in vertrauenswürdige, risikobereinigte Geschwindigkeit.

Übernehmen Sie die Kontrolle über Ihre KI

Shadow AI ist in einer schnelllebigen Entwickler-Welt unvermeidlich, muss aber kein unbeherrschbares Risiko sein. Indem Sie erkennen, dass KI-Assets mittlerweile ein integraler Bestandteil Ihrer Lieferkette sind, können Sie Ihr vorhandenes Fachwissen in den Bereichen Artefaktmanagement, Sicherheit und Durchsetzung von Richtlinien auf diesen neuen Bereich anwenden.

Der AI Catalog bietet die Transparenz, um alle nicht verwalteten Assets zu erkennen, und die Steuerungsebene, um diese zu verwalten, sodass Sie KI sicher und in großem Umfang einsetzen können.

Bereit, Shadow AI zu eliminieren und Ihre KI-Workflows unter Kontrolle zu bringen? Treffen Sie unsere Experten und starten Sie noch heute einen Scan.