JFrog & Qwak: Beschleunigen der Produktionsreife von Modellen – DevOps

Wir freuen uns gemeinsam, einige aufregende Neuigkeiten zu teilen: Qwak wird Teil der JFrog-Familie! Vor fast vier Jahren wurde Qwak mit der Vision gegründet, Ingenieuren für maschinelles Lernen (ML) die Möglichkeit zu bieten, wirklichen Einfluss mit ihren ML-basierten Produkten auszuüben und bedeutende Geschäftsergebnisse zu erzielen. Unsere Mission war es schon immer, die Bereitstellung von ML-Anwendungen zu beschleunigen, zu skalieren und zu sichern.

Dieses neue Kapitel mit JFrog ist ein wichtiger Meilenstein der Qwak-Reise, und wir freuen uns auf die Zusammenarbeit. Die Erstellung von ML-Modellen ist komplex und zeitintensiv, und viele Datenwissenschaftler haben Schwierigkeiten, Konzepte in produktionsreife Modelle umzuwandeln – geschweige denn, sie selbst in die Produktion zu bringen. Die Lücke zwischen MLOps- und DevSecOps-Workflows zu schließen, ist entscheidend, um diesen Prozess zu vereinfachen.

Was ist eine ML-Plattform?

Der Aufbau von Modellen für maschinelles Lernen ist eine komplexe und vielschichtige Aufgabe. Es umfasst mehrere kritische Phasen, einschließlich der Modellentwicklung, der Hyperparameterkonfiguration und der Durchführung zahlreicher "Experimente" zur Optimierung der Leistung. Sobald ein zufriedenstellendes Modell erhalten ist, besteht der nächste Schritt darin, ein einsetzbares Artefakt zu erstellen, das für reale Anwendungen in Produktionssysteme integriert werden kann. Dieser Prozess erfordert nicht nur technisches Fachwissen, sondern auch ein tiefes Verständnis der Problemdomäne, sorgfältige Planung und strenge Tests, um die Zuverlässigkeit und Effizienz des Modells in einer Live-Umgebung sicherzustellen.

Diese Aufgabe ist mit dem Aufkommen von generativer KI (GenAI) und Anwendungen mit Large Language Models (LLMs) noch komplizierter geworden. Herkömmliche ML-Modelle konzentrieren sich in der Regel auf bestimmte Aufgaben wie Klassifizierung, Regression oder Clustering auf der Grundlage strukturierter oder halbstrukturierter Daten. Im Gegensatz dazu sind LLMs, wie sie in GenAI verwendet werden, darauf ausgelegt, menschenähnlichen Text zu verstehen und zu generieren, wodurch sie für eine Vielzahl von Anwendungen wie die Verarbeitung natürlicher Sprache, Konversationsagenten und die automatisierte Erstellung von Inhalten geeignet sind (dies zeigt sich am rasanten Aufstieg von ChatGPT und ähnlichen Technologien sowie an den unzähligen Chatbots und "Assistenten"-Technologien). Der Umfang der Operationen und die Dynamik der Interaktionen in GenAI-Anwendungen erhöhen die Anforderungen an die Entwicklungs- und Bereitstellungsprozesse erheblich, so dass es unerlässlich ist, über spezialisierte Tools und Strategien zu verfügen, um diese Herausforderungen effektiv zu bewältigen.

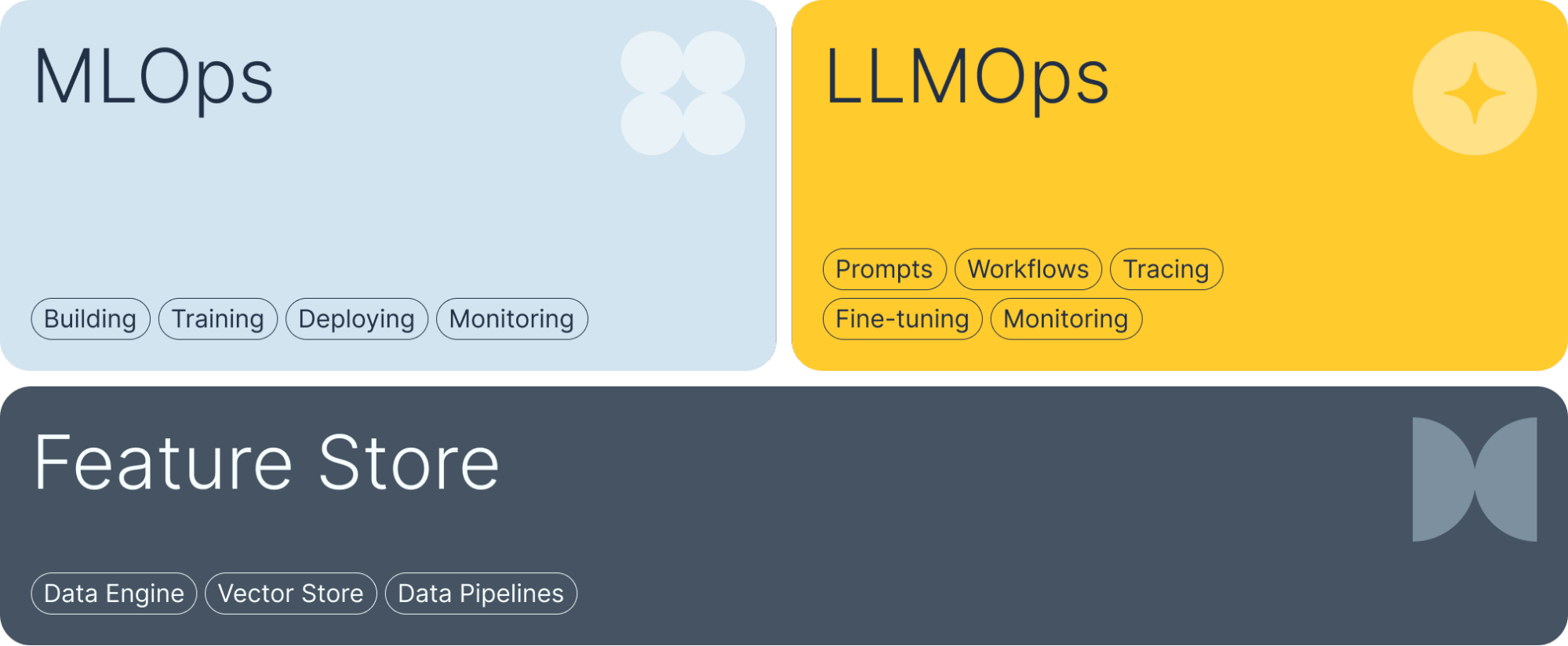

ML-Plattformen wie Qwak adressieren drei kritische Bereiche innerhalb dieser Herausforderungen, um Unternehmen bei der Bewältigung der Komplexität bei der Bereitstellung von maschinellem Lernen und KI-Anwendungen zu unterstützen:

- MLOps: Umfassende Lösungen zum Erstellen, Trainieren und Bereitstellen von Machine Learning-Modellen. Von der Versuchsverwaltung bis zur Produktionsbereitstellung deckt dieser Bereich den gesamten Lebenszyklus von ML-Modellen ab und gewährleistet Effizienz und Skalierbarkeit.

- LLMOps: Mit Speziallösungen lassen sich die einzigartigen Herausforderungen großer sprachmodellbasierter Anwendungen meistern. Dazu gehören die Verwaltung von Aufforderungen, der Umgang mit komplexen Architekturen und die Implementierung fortschrittlicher Überwachungstechniken, um optimale Leistung und Zuverlässigkeit zu liefern.

- Feature-Store: Eine robuste Daten-Engine, die die Anforderungen von Data Scientists unterstützt, einschließlich Featurepipelines, Featurebereitstellung und der Möglichkeit, Vektoren zu erstellen und zu speichern. Diese Komponente stellt sicher, dass die richtigen Daten für die Modellentwicklung und -bereitstellung leicht verfügbar sind.

Vorteile der Zusammenarbeit von JFrog und Qwak

Während MLOps-Plattformen Data Scientists die Arbeit an Modellen bis zur Produktionsreife in vielen Punkten erleichtern, gibt es viele Bereiche, die sie möglicherweise nicht im Alleingang bewältigen können. Nach unserer ersten Integration und während wir gemeinsam an vollständig integrierten Lösungen arbeiten, ergänzen sich JFrog und Qwak, um Einzelpersonen und Unternehmen dabei zu helfen, schneller und zuverlässiger hochwertige KI-Ergebnisse zu liefern. Dies lässt sich auf drei Schlüsselbereiche reduzieren:

- Beschleunigte Entwicklung: Durch die Integration der verwalteten ML-Plattform von Qwak mit den DevSecOps-Werkzeugen von JFrog können Entwicklungsteams ihre Arbeitsabläufe optimieren und die Zeit von der Modellkonzeption bis zur Produktionsreife verkürzen.

- Verbesserte Sicherheit: Die umfassende Sicherheitssuite von JFrog sorgen dafür, dass ML-Modelle in jeder Phase des Lebenszyklus sicher sind, von der Entwicklung bis zum Einsatz. Diese Integration wird dazu beitragen, Schwachstellen zu erkennen und Risiken bei herkömmlichen Komponenten und ML-Modellen selbst frühzeitig zu mindern.

- Verbesserte Zusammenarbeit: Diese Integration wird eine bessere Zusammenarbeit zwischen Datenwissenschaftlern, Entwicklern und Sicherheitsteams fördern. Durch die Verwendung einer gemeinsamen Plattform können diese Teams effektiver zusammenarbeiten, was zu qualitativ hochwertigeren Software-Releases und weniger Zeit für die Bearbeitung von Problemen über Toolsets und Abteilungen hinweg führt.

TIPP: Um sofort mit JFrog- und Qwak-Lösungen zu beginnen, lesen Sie bitte diese Schritt-für-Schritt-Anleitung.

Sowohl ML-Engineering-/Data-Science-Teams als auch DevSecOps-Experten werden wichtige technische Funktionen zur gegenseitigen Unterstützung erkennen, die die Arbeit vereinfachen und beschleunigen:

- Einheitliche Pipeline: Eine einzige, zusammenhängende Software-Supply-Chain-Pipeline für ML-Modellmanagement und Softwareentwicklung sorgt für reibungslosere Übergänge zwischen den Phasen und reduziert Fehler.

- Versionskontrolle für ML-Assets: Sowohl Qwak als auch JFrog bieten eine robuste Versionskontrolle für alle Modell-Assets und zugehörige Abhängigkeiten, die es Teams ermöglicht, Änderungen zu verfolgen, Versionen zu verwalten und bei Bedarf einen Rollback durchzuführen – eine wichtige Funktion, wenn Probleme entdeckt werden.

- Compliance und Überprüfbarkeit: Die Integration bietet Einblick in den Sicherheits- und Compliance-Status aller Modelle und fördert das Vertrauen der Organisation in Open-Source-Modelle für maschinelles Lernen.

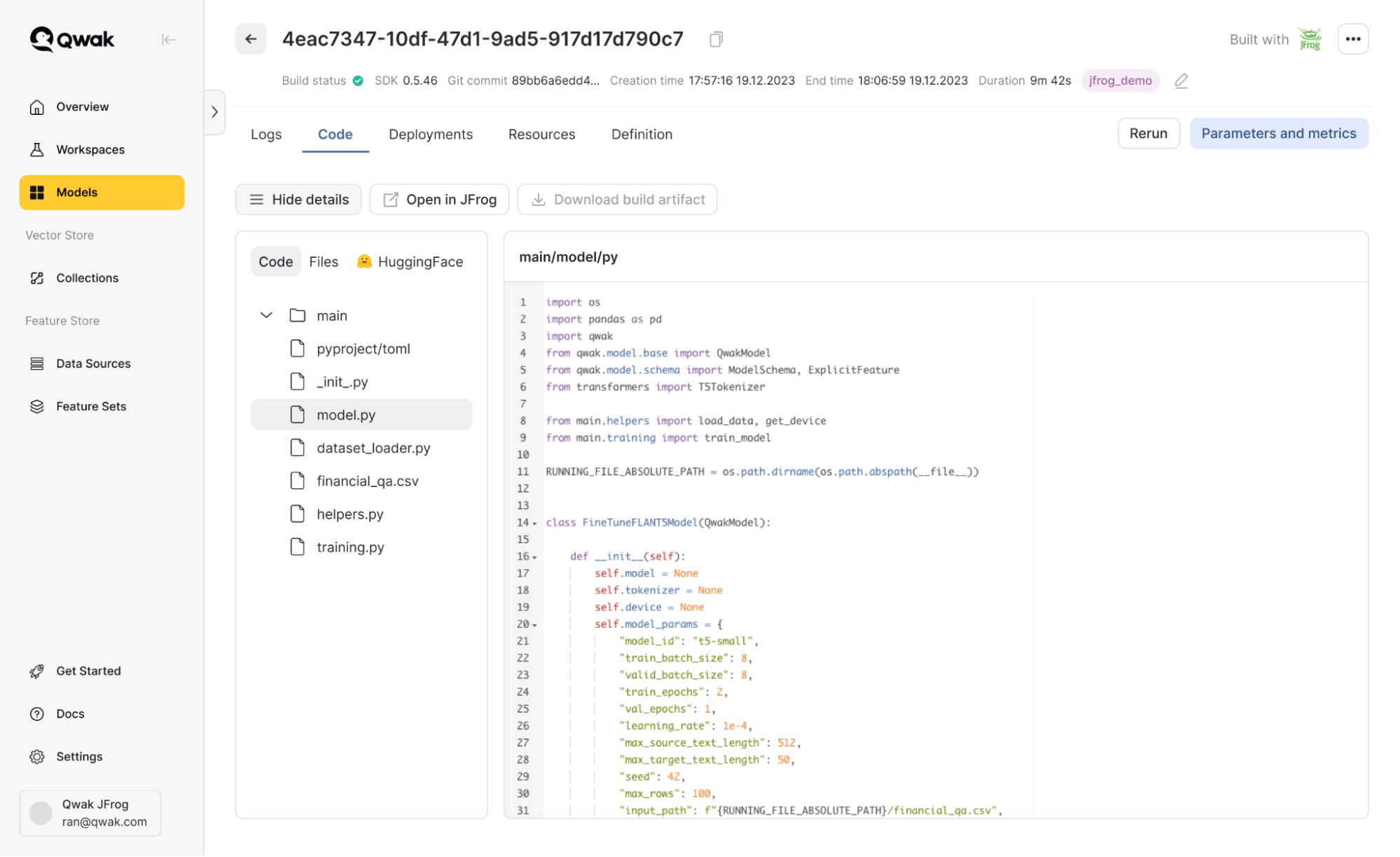

Nehmen wir beispielsweise an, Sie möchten ein Flan-T5-Modell auf der Qwak-Plattform feinabstimmen. Dieses Modell ist über Hugging Face zugänglich. Mit den integrierten Funktionen:

- Das Modell wurde unter Verwendung der Caching- und Compliance-Fähigkeiten von JFrog direkt aus dessen virtuellen Hugging Face-Repository heruntergeladen.

- Das Modell wurde mithilfe der Funktionen für das Build-System und die Infrastrukturverwaltung von Qwak trainiert.

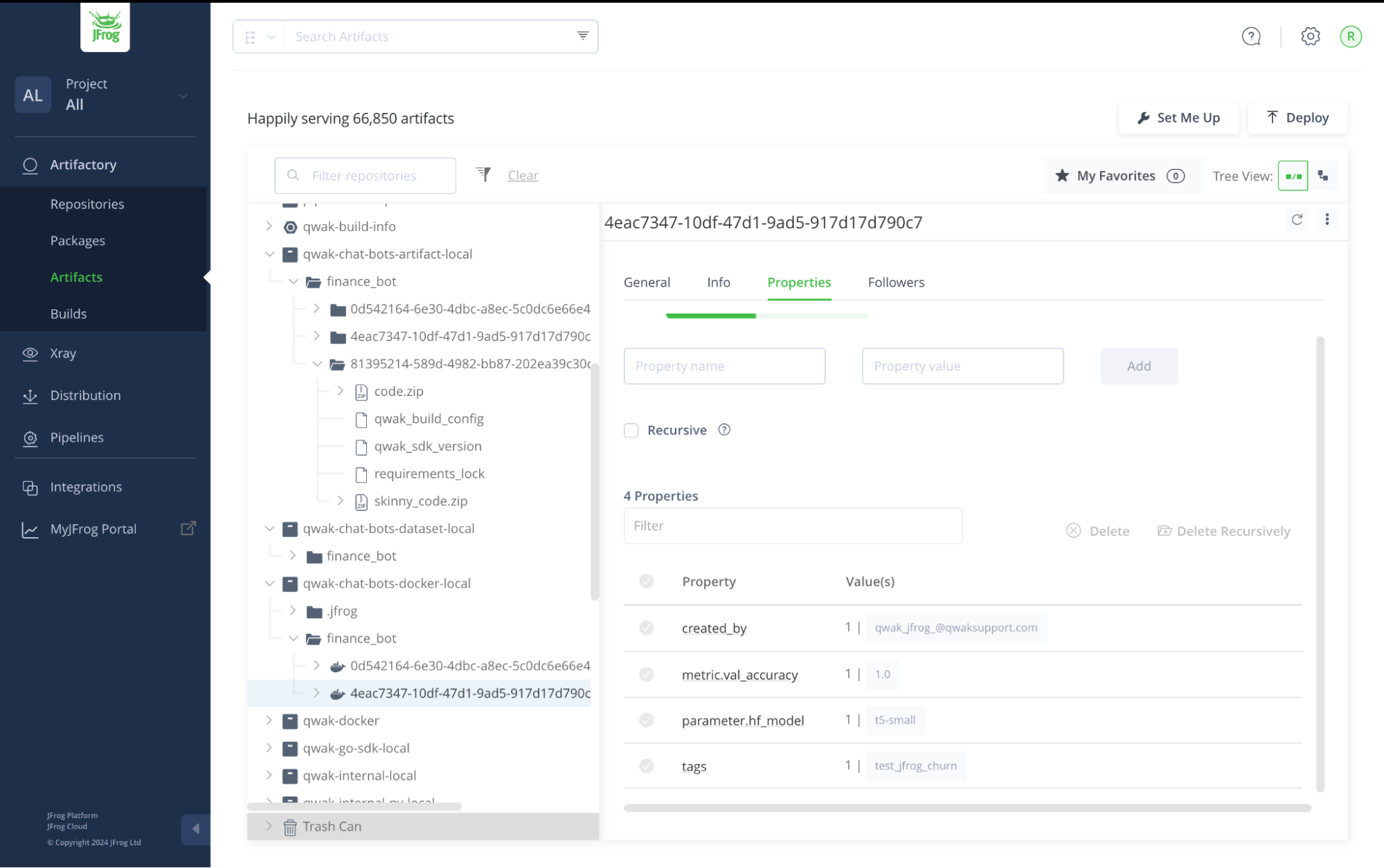

- Alle Artefakte, einschließlich des trainierten Modells, des bereitstellbaren Docker-Containers und der Hyperparameter, wurden in meinem JFrog-Konto gespeichert.

Feinabstimmung eines Flan-T5-Modells in der Qwak-Plattform

Alle Modellartefakte in JFrog Artifactory gespeichert

Wechsel von MLOps zu MLSecOps

Während des Build-Prozesses im obigen Beispiel ruft Qwak HuggingFace-Modelle über Artifactory ab. Jedes Modell wird im Remote-Repository zwischengespeichert und von JFrog Xray und JFrog Advanced Security gescannt, die nicht nur auf Schwachstellen prüfen, sondern auch die Lizenzierung des Modells untersuchen. Dieser umfassende Scan stellt sicher, dass jedes Modell hohe Sicherheitsstandards erfüllt. Darüber hinaus werden alle in JFrog konfigurierten Xray-Richtlinien und Überwachungsmaßnahmen eingehalten, um für eine konsistente Durchsetzung der Richtlinien und einen hohen Sicherheitsstatus zu sorgen.

Diese Integration wird bald über herkömmliche MLOps hinausgehen und erweiterte Sicherheits- und Compliance-Maßnahmen integrieren:

- Echtzeit-Analyse von Abhängigkeiten: JFrog Xray scannt kontinuierlich Abhängigkeiten auf Schwachstellen und bietet Echtzeit-Einblicke in potenzielle Sicherheitsrisiken.

- Kontinuierliche Kontrolle und Compliance: Die Tools von JFrog setzen Compliance-Richtlinien durch und stellen sicher, dass alle Artefakte und Modelle den Branchen- und Regulierungsstandards entsprechen. Alle in JFrog konfigurierten Richtlinien und Überwachungsmaßnahmen werden respektiert, um einen konsistenten Sicherheitsstatus aufrechtzuerhalten.

- Modell-Kuration: Nicht konforme Komponenten werden automatisch blockiert, um sicherzustellen, dass nur sichere und konforme Modelle in der Produktion bereitgestellt werden.

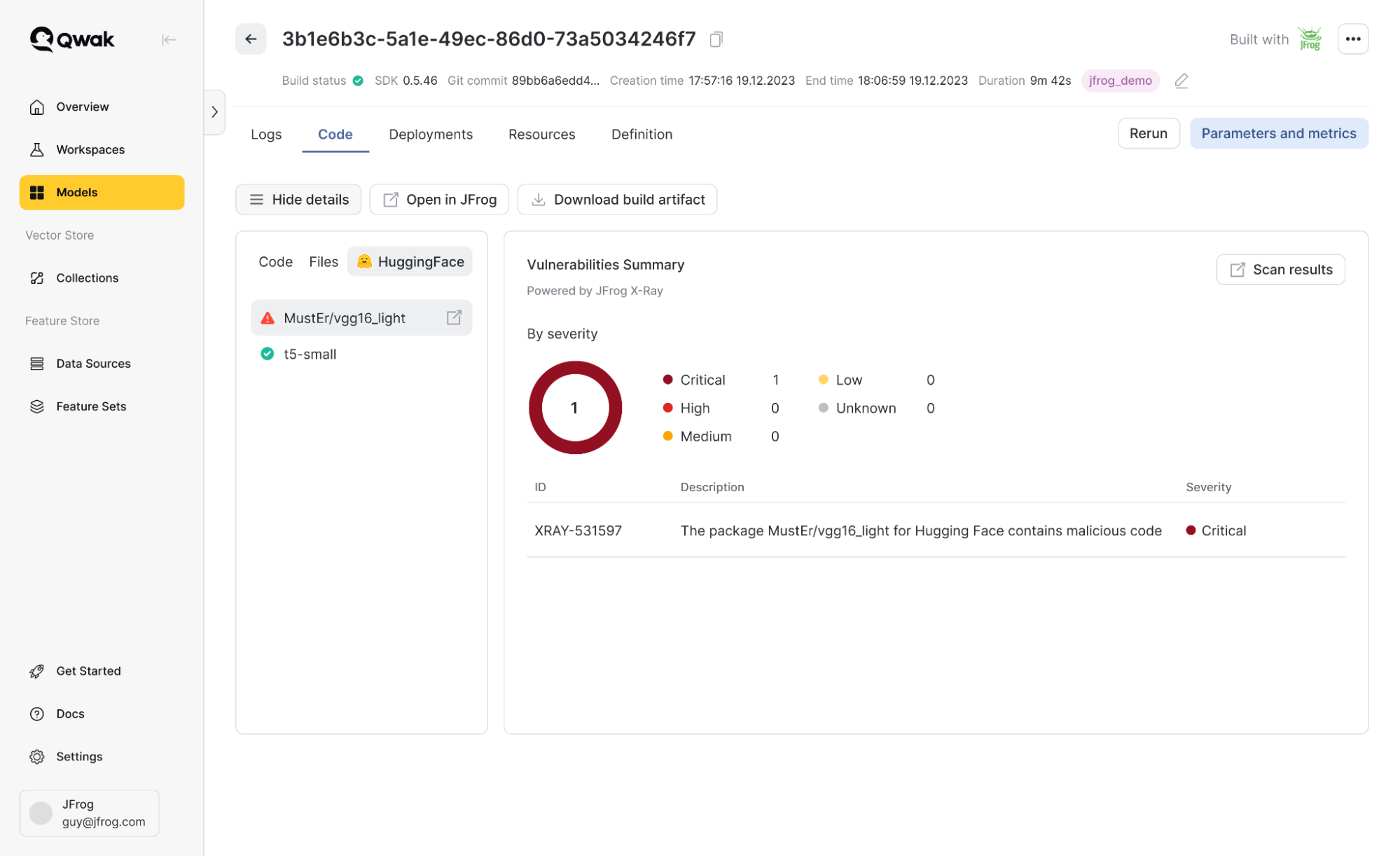

Kehren wir zum obigen Beispiel zurück und betrachten wir ein Szenario, in dem eines meiner Modelle bösartigen Code enthält. JFrog scannt die Modelle automatisch. Wird eine Schwachstelle entdeckt, können die Details angezeigt werden und die Modellnutzung mit den vorhandenen JFrog-Richtlinien verwaltet werden. Zum Beispiel könnte ich jedes Modell, das kritische Schwachstellen aufweist, automatisch blockieren.

Von JFrog Xray entdeckte Schwachstellen in Modellen

Warum wir „gemeinsam besser“ sind

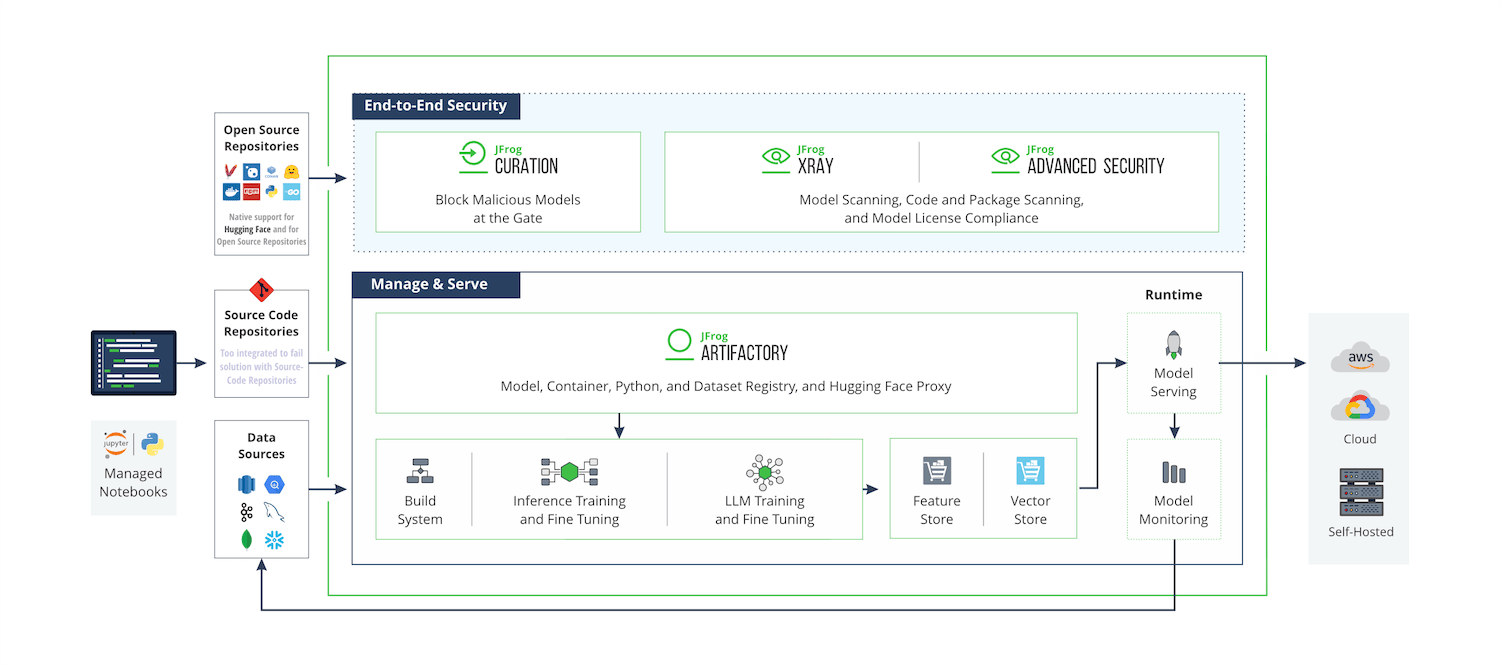

Die Vision von JFrog ist es, eine vertrauenswürdige und nahtlose Software-Lieferkette vom Entwickler bis zum Gerät zu ermöglichen, indem der gesamte Lebenszyklus von Software-Releases verwaltet und gesichert wird. Da ML-Modelle und KI-Anwendungen zu einem integralen Bestandteil der meisten Softwareprodukte werden, zielen JFrog und Qwak darauf ab, KI/ML-basierte Softwareversionen zu verbessern, um sicherzustellen, dass wir den Marktanforderungen immer einen Schritt voraus sind.

Plattform-Diagramm: Geplante technische Ergebnisse der Partnerschaft von JFrog und Qwak

Es sollte offensichtlich sein, dass der einzige effiziente Weg, um die Produktion von Modellen zu rationalisieren, eine nicht nur "integrierte", sondern vollständig einheitliche Lösung ist, die die End-to-End-Pipeline von ML-Modellen, KI-Komponenten und herkömmlicher Software umfasst. Als geschäftskritischer Teil der Softwareinfrastruktur der Kunden erfüllt die JFrog Platform diese Vision, mit der Ergänzung der ML-Plattform von Qwak, die die erforderliche KI-Bereitstellungstechnologie bietet, um Kundenlösungen auf ihre KI-Initiativen auszuweiten.

Gemeinsam helfen JFrog und Qwak Ihnen, Governance, Transparenz, Sichtbarkeit und Sicherheit in jeder Facette des Entwicklungs- und Bereitstellungslebenszyklus für ML-Modelle zu etablieren. Mit einem "Model as a Package"-Ansatz bieten wir eine einfache, vertrauenswürdige Software-Lieferkette für ML- und KI-gestützte Anwendungen, die das Verschieben von Modellen in die Produktion zu einem vollautomatischen Prozess macht, der für jedes Unternehmen skalierbar ist. Von der Verwaltung von Abhängigkeiten über die Sicherstellung der Compliance bis hin zur Optimierung des Speichers ermöglicht diese Integration Ihrem Unternehmen, maschinelles Lernen mit Zuversicht und Effizienz zu nutzen. Darüber hinaus überbrückt es die Lücken zwischen ML-Ingenieuren und dem Rest der Entwicklungsteams – insbesondere angesichts des Aufkommens von GenAI-Anwendungen – und macht die Zusammenarbeit für ein ganzes Unternehmen natürlicher und nahtloser.

Was kommt als nächstes?

Am 22. Juli 2024 waren wir Gastgeber eines tiefergehenden Webinars, in dem wir reale Anwendungsfälle zur Verbesserung Ihrer MLOps-Reise untersucht haben. Wenn Sie nicht teilnehmen konnten, machen Sie sich keine Sorgen – Sie können sich das Webinar auf Abruf ansehen. Wie JFrog immer sagt: “May the Frog be With You”, jetzt auch mit etwas “Entenpower”!