JFrog et Qwak : Accélérer les modèles d'apprentissage automatique en production – La méthode DevOps

Toute l’équipe est ravie de partager des nouvelles exaltantes : Qwak rejoindra la famille JFrog ! Il y a près de quatre ans, Qwak a été fondée avec la vision de donner aux ingénieurs en machine learning (ML) les moyens d’avoir un impact réel avec leurs produits basés sur le ML et d’obtenir des résultats commerciaux significatifs. Notre mission a toujours été d’accélérer, de faire évoluer et de sécuriser la livraison d’applications ML.

Ce nouveau chapitre avec JFrog marquera une étape importante dans l’aventure Qwak, et nous ne pourrions pas être plus enthousiastes à l’idée d’aller de l’avant ensemble. La création de modèles ML est complexe et prend beaucoup de temps, et de nombreux scientifiques des données ont du mal à transformer les concepts en modèles prêts pour la production, sans parler de les mettre eux-mêmes en production. Il est essentiel de combler le fossé entre les workflows MLOps et DevSecOps pour rationaliser ce processus.

Qu’est-ce qu’une plateforme ML ?

La création de modèles de machine learning est une tâche complexe et multidimensionnelle. Elle implique plusieurs étapes critiques, notamment le développement du modèle, la configuration des hyperparamètres et l’exécution de nombreuses « expérimentations » pour optimiser les performances. Une fois qu’un modèle satisfaisant est obtenu, l’étape suivante consiste à créer un artefact déployable, qui peut être intégré dans des systèmes de production pour des applications réelles. Ce processus nécessite non seulement une grande compétence technique, mais aussi une compréhension approfondie du domaine d’application, une planification minutieuse et des tests rigoureux pour garantir la fiabilité et l’efficacité du modèle dans un environnement réel.

Cette tâche est devenue encore plus compliquée avec l’avènement de l’IA générative (GenAI) et des applications impliquant de grands modèles de langage (LLM). Les modèles ML traditionnels se concentrent généralement sur des tâches spécifiques telles que la classification, la régression ou le clustering basés sur des données structurées ou semi-structurées. En revanche, les LLM, comme ceux utilisés dans GenAI, sont conçus pour comprendre et générer du texte de type humain, ce qui les rend adaptés à un large éventail d’applications telles que le traitement du langage naturel, les agents conversationnels et la création de contenu automatisé (cela peut être vu dans l’essor rapide de ChatGPT et de technologies similaires, ainsi que la myriade de chatbots et de technologies « assistantes »). L’échelle des opérations et la nature dynamique des interactions dans les applications GenAI augmentent considérablement les exigences sur les processus de développement et de déploiement, ce qui rend essentiel de disposer d’outils et de stratégies spécialisés pour relever efficacement ces défis.

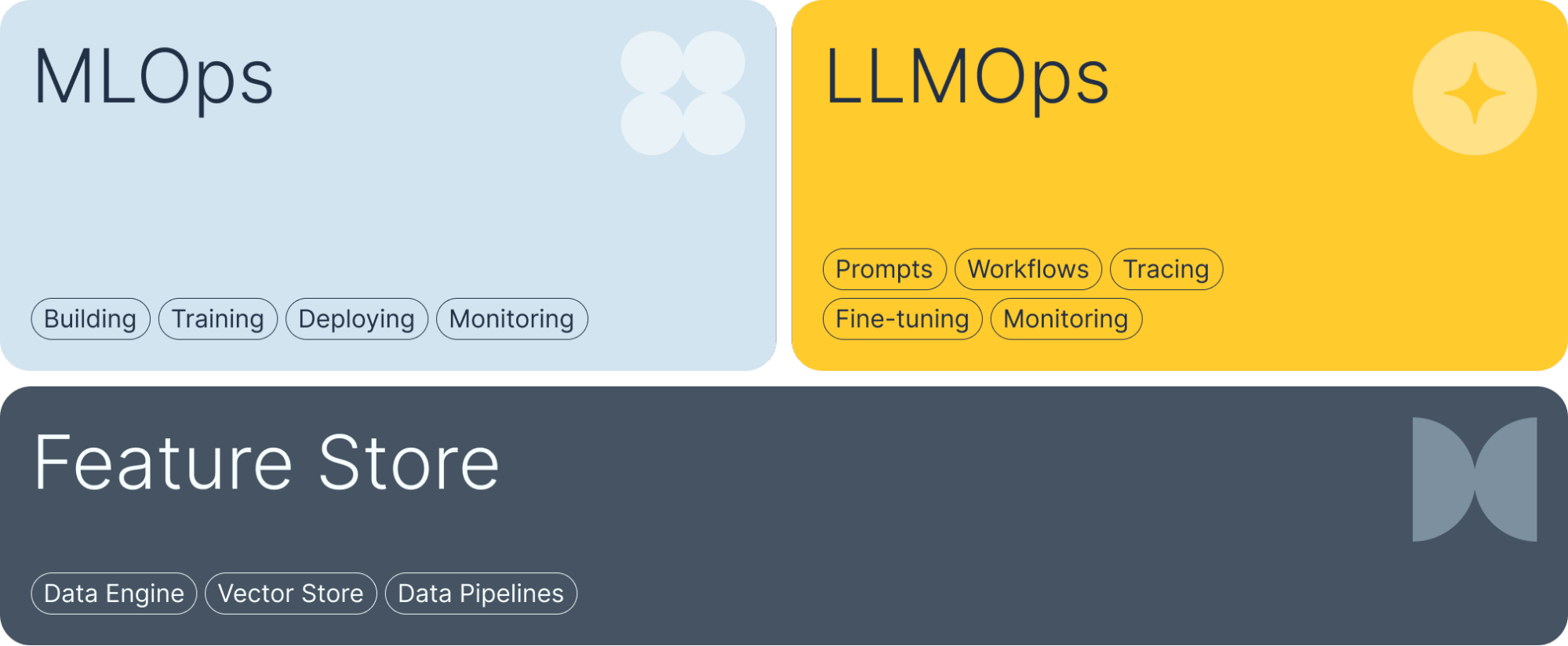

Les plateformes de ML telles que Qwak répondent à trois domaines critiques de ces défis pour aider les organisations à surmonter les complexités lors de la fourniture d’applications de machine learning et d’IA :

- MLOps : Des solutions complètes pour la création, l’entraînement et le déploiement de modèles de Machine Learning. De la gestion des expériences au déploiement en production, ce domaine couvre l’ensemble du cycle de vie des modèles ML, garantissant efficacité et évolutivité.

- LLMOps : Des solutions spécialisées pour relever les défis uniques des grandes applications basées sur des modèles de langage. Cela inclut la gestion des invites, la gestion d’architectures complexes et la mise en œuvre de techniques de surveillance avancées pour garantir des performances et une fiabilité optimales.

- Boutique de fonctionnalités : Un moteur de données robuste qui répond aux besoins des data scientists, comprenant les pipelines de fonctionnalités, la mise à disposition de fonctionnalités et la possibilité de créer et de stocker des vecteurs. Ce composant garantit que les bonnes données sont facilement disponibles pour le développement et le déploiement du modèle.

Pourquoi JFrog et Qwak ensemble ?

Si les plateformes MLOps facilitent la vie des data scientists de plusieurs façons lors de la mise en production de modèles, il existe de nombreux domaines qu’elles ne peuvent pas aborder en silo. Suite à notre intégration initiale, et alors que nous travaillons ensemble à des solutions plus intégrées, JFrog et Qwak se complètent pour aider les particuliers et les entreprises à tirer parti de la valeur de l’IA plus rapidement et avec une plus grande confiance. Cela se résume à trois domaines clés :

- Développement accéléré : En intégrant la plateforme de ML gérée de Qwak aux outils DevSecOps de JFrog, les équipes de développement pourront rationaliser leurs flux de travail, réduisant ainsi le temps nécessaire pour faire passer les modèles de la conception à la production.

- Sécurité améliorée : La suite de sécurité complète de JFrog garantit que les modèles ML sont sécurisés à chaque étape du cycle de vie, du développement au déploiement. Cette intégration permettra d’identifier les vulnérabilités et atténuer les risques à un stade précoce dans les composants traditionnels et les modèles d’apprentissage automatique eux-mêmes.

- Amélioration de la collaboration : Cette intégration favorisera une meilleure collaboration entre les scientifiques des données, les développeurs et les équipes de sécurité. En utilisant une plateforme commune, ces équipes peuvent travailler ensemble plus efficacement, ce qui permet d’obtenir des versions logicielles de meilleure qualité et de réduire le temps consacré à la résolution des problèmes entre les outils et les départements.

ASTUCE : Pour commencer à utiliser immédiatement les solutions JFrog et Qwak, veuillez consulter ces instructions étape par étape.

Les équipes d’ingénierie ML/Data Science et les professionnels DevSecOps reconnaîtront les principales fonctionnalités techniques qui stimulent la simplicité et la rapidité :

- Pipeline unifié : Un pipeline de chaîne d’approvisionnement logicielle unique et cohérent pour la gestion des modèles ML et le développement de logiciels garantit des transitions plus fluides entre les étapes, réduisant ainsi les frictions et les erreurs.

- Contrôle de version pour les actifs ML : Qwak et JFrog offrent tous deux un contrôle de version robuste pour tous les actifs du modèle et les dépendances associées, permettant aux équipes de suivre les modifications, de gérer les versions et de revenir en arrière si nécessaire – une fonctionnalité clé si des problèmes sont découverts.

- Conformité et auditabilité : L’intégration offre une visibilité sur l’état de sécurité et de conformité de tous les modèles, favorisant ainsi la confiance de l’organisation dans les modèles de machine learning open source.

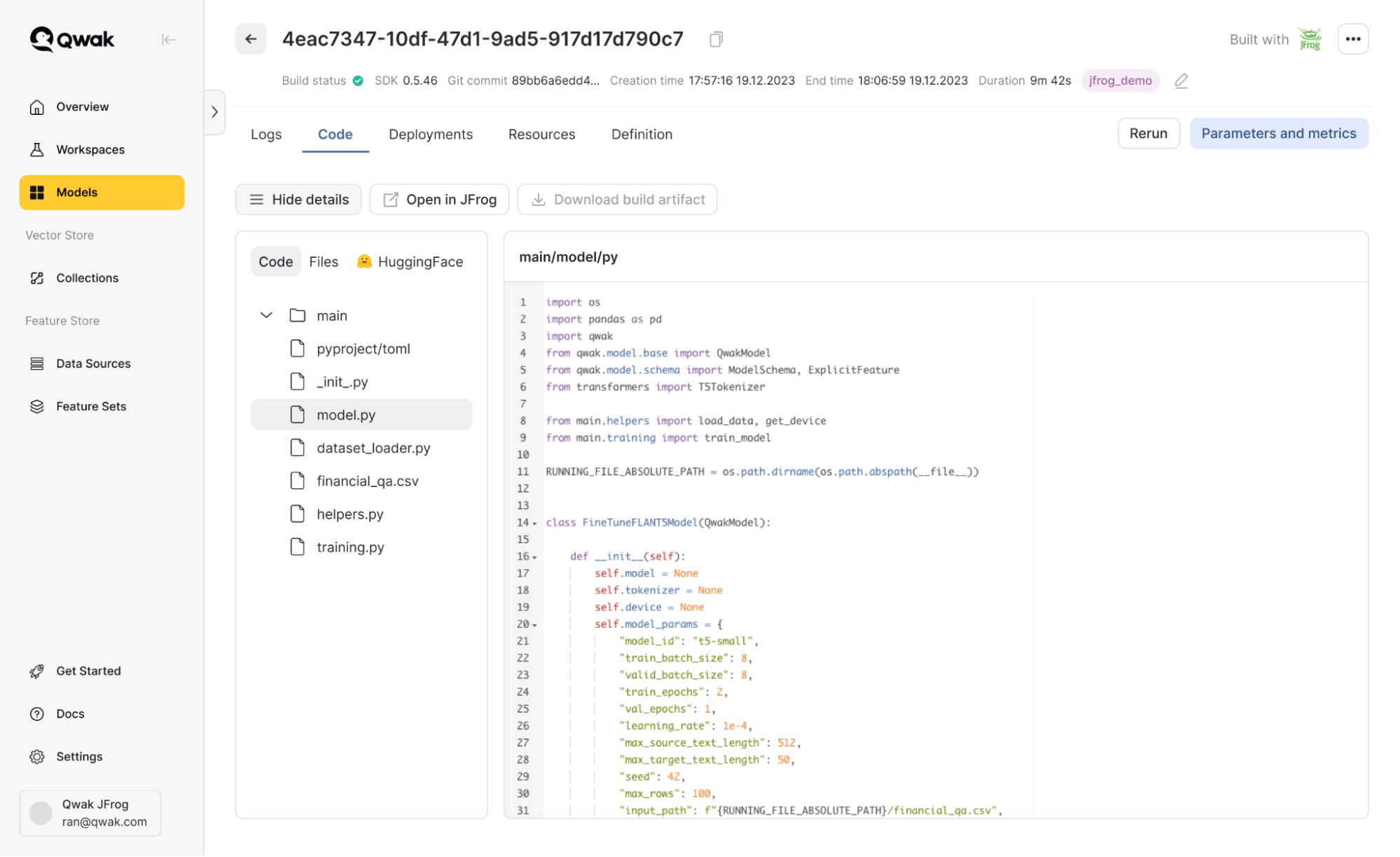

Prenons un exemple ; disons que je peaufine un modèle Flan-T5 sur la plateforme Qwak. Ce modèle est accessible via Hugging Face. Avec les fonctionnalités intégrées :

- J’ai téléchargé le modèle directement depuis le dépôt virtuel Hugging Face de JFrog, en tirant parti des capacités de cache et de conformité de JFrog.

- J’ai entraîné mon modèle sur Qwak, en utilisant son système de construction et ses fonctionnalités de gestion d’infrastructure.

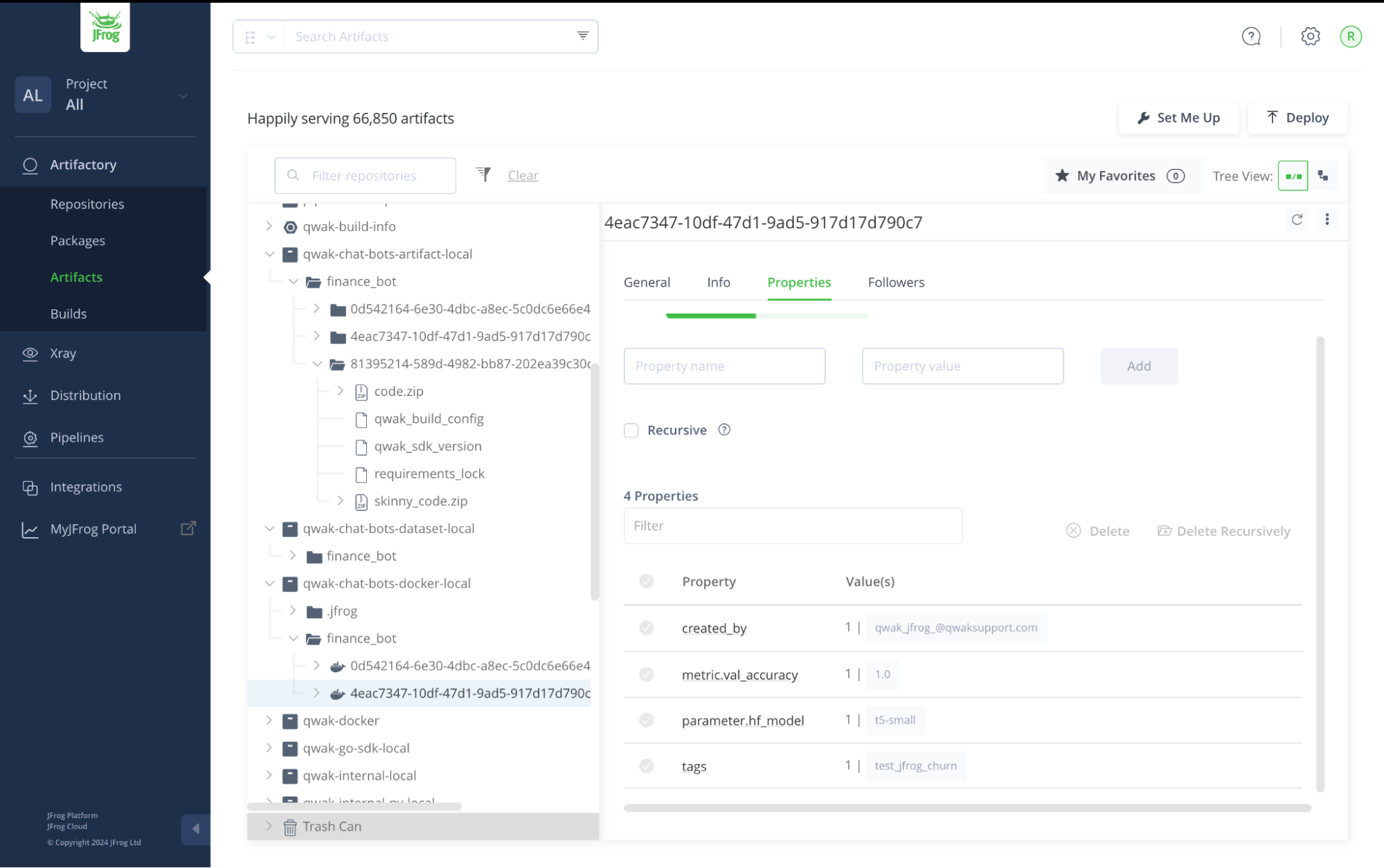

- Tous les artefacts, y compris le modèle entraîné, le conteneur Docker déployable et les hyperparamètres, ont été enregistrés dans mon compte JFrog.

Ajustement fin d’un modèle Flan-T5 dans la plateforme Qwak

Tous les artefacts du modèle enregistrés dans JFrog Artifactory

Passer du MLOps au MLSecOps

Pendant le processus de construction dans l’exemple ci-dessus, Qwak récupère les modèles HuggingFace via Artifactory. Chaque modèle est mis en cache dans le dépôt distant et analysé par JFrog Xray et JFrog Advanced Security, qui non seulement vérifie les vulnérabilités, mais examine également la licence du modèle. Cette analyse complète garantit que chaque modèle répond à des normes de sécurité élevées. De plus, toutes les politiques et Watches Xray configurées dans JFrog sont respectées, ce qui garantit une application cohérente des politiques et une posture de sécurité correcte.

Cette intégration s’étendra bientôt au-delà du MLOps traditionnel en intégrant des mesures de sécurité et de conformité plus avancées :

- Analyse en temps réel des dépendances : JFrog Xray analyse en permanence les dépendances à la recherche de vulnérabilités, fournissant des informations en temps réel sur les risques de sécurité potentiels.

- Contrôle et conformité continus : Les outils de JFrog appliquent les politiques de conformité, garantissant que tous les artefacts et modèles répondent aux normes industrielles et réglementaires. Toutes les politiques et les Watches configurés dans JFrog sont respectés, ce qui permet de maintenir une posture de sécurité cohérente.

- Curation de modèle : Les composants non conformes sont automatiquement bloqués, ce qui garantit que seuls les modèles sécurisés et conformes sont déployés en production.

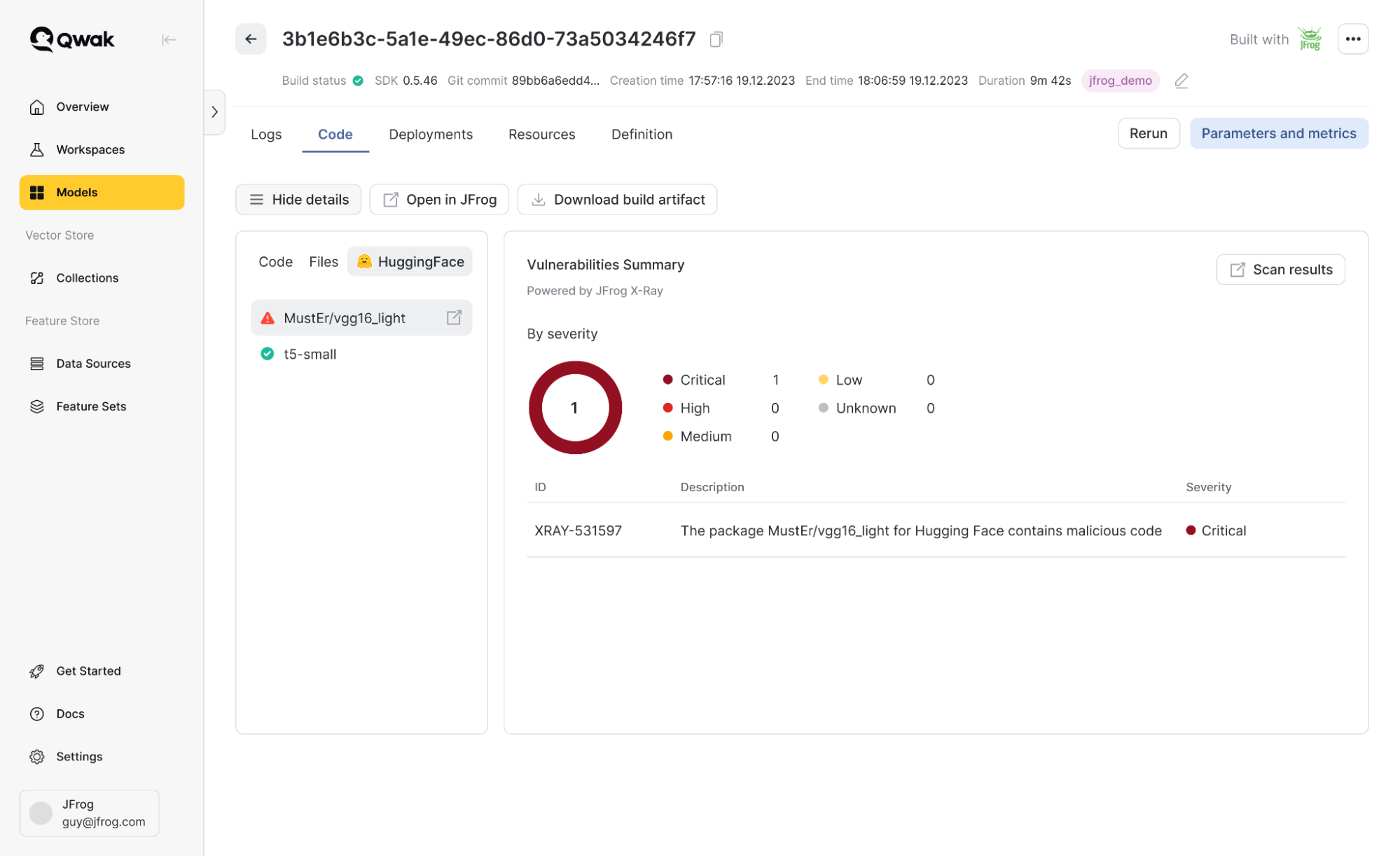

Pour revenir à l’exemple ci-dessus, considérons un scénario où l’un de mes modèles contient du code malveillant. JFrog scanne automatiquement mes modèles ; si une vulnérabilité est détectée, je peux afficher les détails et utiliser mes politiques JFrog existantes pour gérer l’utilisation du modèle. Par exemple, je pourrais bloquer automatiquement tout modèle présentant des vulnérabilités critiques.

Vulnérabilités des modèles détectées par JFrog Xray

Pourquoi nous sommes « meilleurs ensemble »

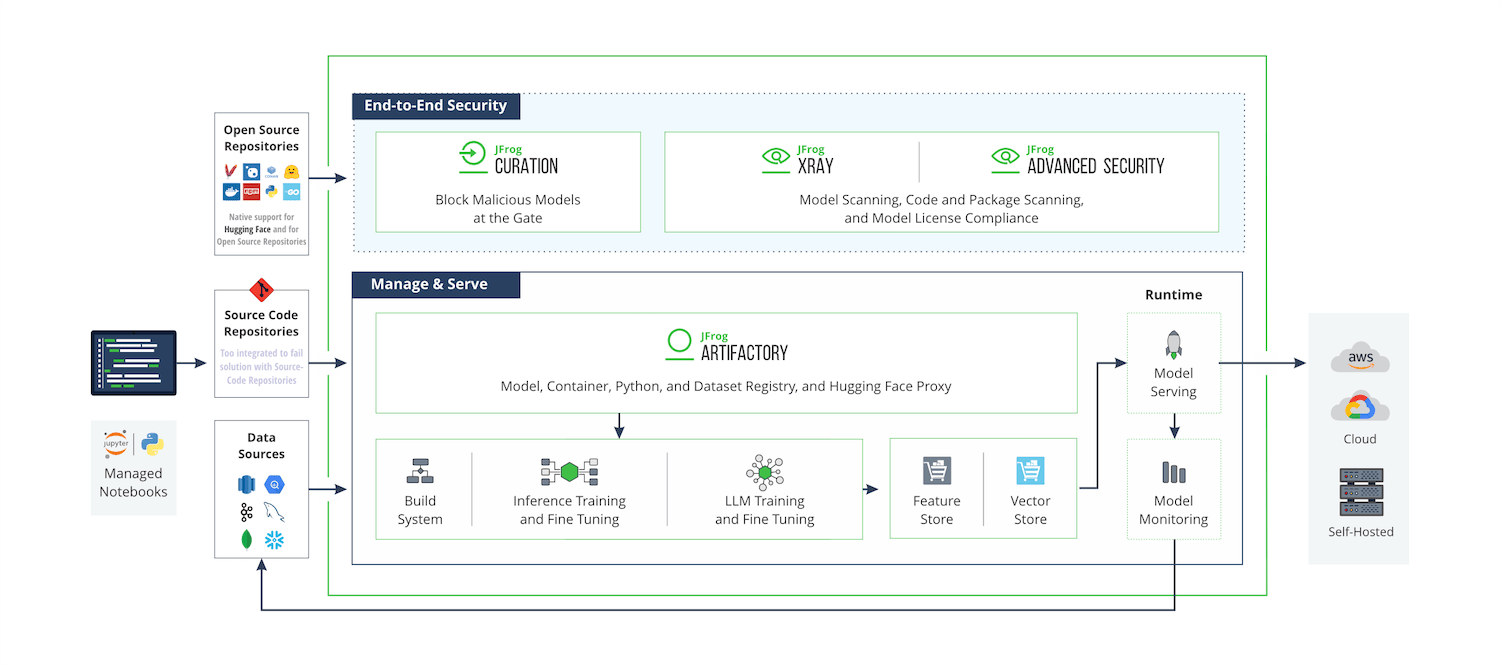

La vision de JFrog est de permettre une chaîne d’approvisionnement logicielle fiable et transparente, du développeur à l’appareil, en gérant et en sécurisant le cycle de vie complet des versions logicielles. Alors que les modèles de ML et les applications d’IA font partie intégrante de la plupart des produits logiciels, JFrog et Qwak visent à améliorer les versions logicielles basées sur l’IA/ML, en veillant à ce que nous gardions une longueur d’avance sur les demandes du marché.

Schéma de la plate-forme : Résultats techniques prévus de la fusion de JFrog et Qwak

Il devrait être évident que le seul moyen efficace de rationaliser l’intégration des modèles en production est une solution non seulement « intégrée », mais entièrement unifiée qui couvre le pipeline de bout en bout des modèles ML, des composants d’IA et des logiciels traditionnels. En tant qu’élément essentiel de l’infrastructure logicielle des clients, la plateforme JFrog répond à cette vision, avec l’ajout de la plateforme ML de Qwak apportant la technologie de déploiement de l’IA nécessaire pour étendre les solutions des clients à travers leurs initiatives d’IA.

Ensemble, JFrog et Qwak vous aideront à établir la gouvernance, la transparence, la visibilité et la sécurité dans toutes les facettes du cycle de vie du développement et du déploiement des modèles ML. Avec une approche « modèle comme un package », nous fournirons une chaîne d’approvisionnement logicielle simple et fiable pour les applications alimentées par le ML et l’IA, faisant du passage des modèles en production un processus entièrement automatisé qui peut s’adapter à n’importe quelle organisation. De la gestion des dépendances à la conformité et à l’optimisation du stockage, cette intégration permet à votre organisation d’adopter le machine learning en toute confiance et efficacité. De plus, elle comble de manière vitale les écarts entre les ingénieurs ML et le reste des équipes de développement, en particulier à la lumière de l’avènement des applications GenAI, rendant la collaboration plus naturelle et transparente pour toute l’organisation.

Quelle est la prochaine étape?

Le 22 juillet 2024, nous avons organisé un webinaire plus approfondi au cours duquel nous avons exploré des cas d’utilisation concrets pour améliorer votre parcours MLOps. Si vous n’avez pas pu y assister, ne vous inquiétez pas, vous pouvez regarder le webinaire à la demande. Comme le dit toujours JFrog: que la grenouille soit avec vous. Et sans couac!