Comment détecter et éliminer le Shadow AI en 5 étapes

La pression pour intégrer l’IA est immense. Vos développeurs doivent aller toujours plus vite et trouver des moyens de mener à bien leurs tâches. Mais cette course à l’innovation se déroule souvent en dehors des cadres de gouvernance établis, donnant naissance à un risque diffus et invisible : le Shadow AI, également connu sous le nom de l’IA fantôme.

Pour sécuriser votre organisation, vous devez d’abord comprendre ce qu’est réellement le Shadow AI.

Le Shadow AI ne se résume pas à un simple fichier téléchargé par un développeur sur son ordinateur. Elle représente la totalité des actifs d’IA non maîtrisés au sein de votre supply chain, et comprend trois volets distincts, tous aussi dangereux les uns que les autres :

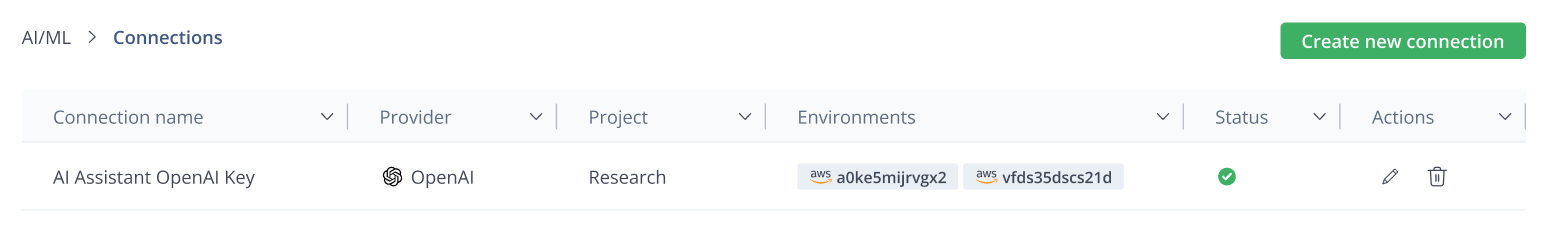

- Appels d’API externes : clés API codées en dur et risques de fuites de données liés aux appels à des services tiers dans votre code.

- Modèles open source : vulnérabilités telles que l’empoisonnement de la supply chain provenant de modèles téléchargés depuis des dépôts publics.

- Modèles personnalisés : modèles propriétaires, développés en interne, qui n’ont pas fait l’objet d’un scan de sécurité ou dont la traçabilité n’est pas vérifiable.

Si vous ne détectez pas et ne gouvernez pas tous les types de ressources d’IA, vous exposez votre organisation à des fuites de données, des injections malveillantes et des violations de licence. Voici cinq étapes concrètes pour les maîtriser à l’aide de JFrog AI Catalog.

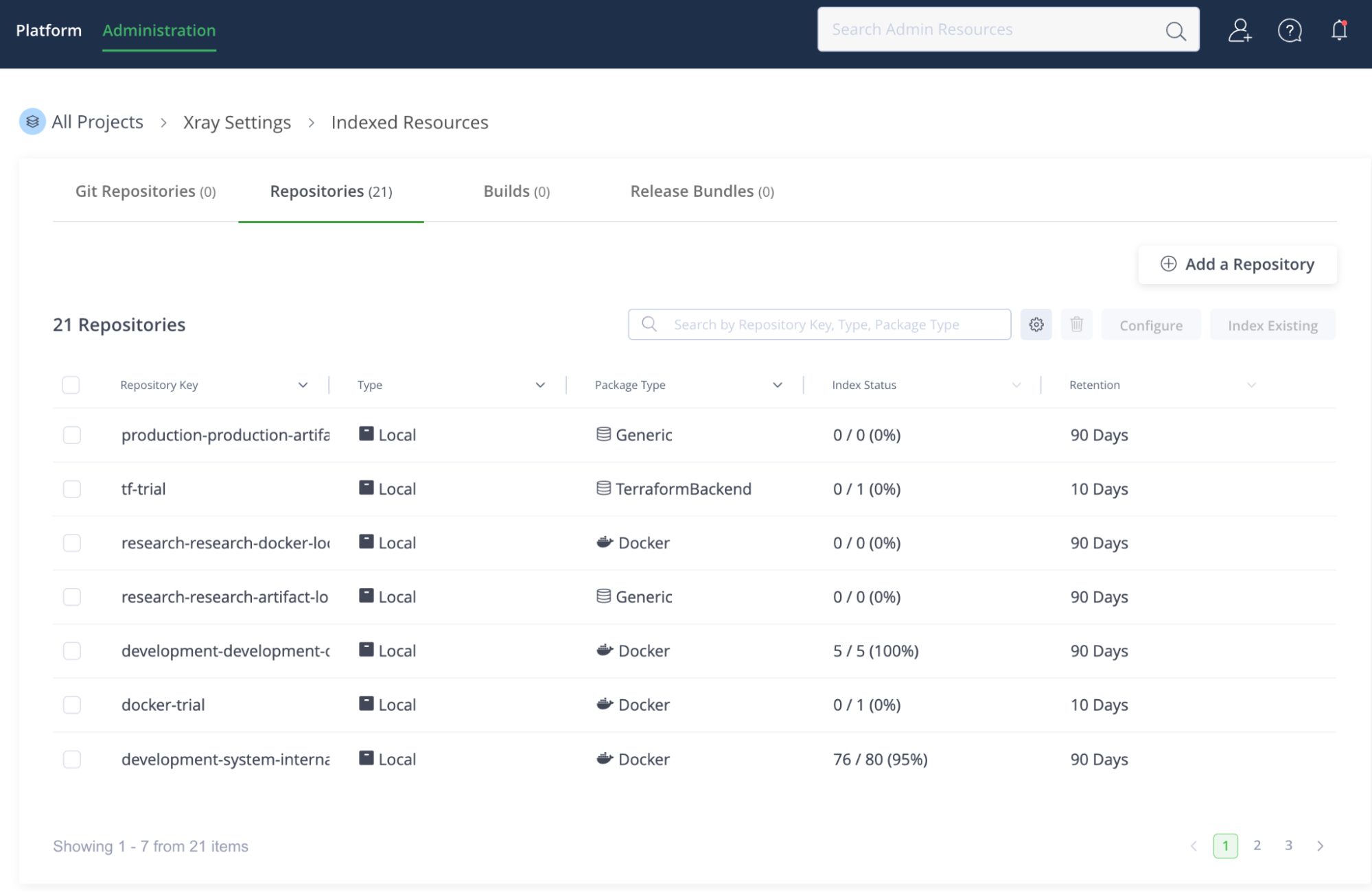

Étape 1 : Scanner vos dépôts existants

La première étape pour reprendre le contrôle du Shadow AI consiste à cesser de supposer et à commencer à auditer. Il vous faut un mécanisme unique capable d’analyser chaque artefact, chaque build et chaque dépôt de code source de votre système afin de détecter l’usage de l’IA, qu’il se trouve dans un fichier binaire ou dans un appel d’API.

Ce processus s’appuie sur les composants de sécurité sous-jacents de JFrog pour trouver les actifs d’IA non gérés sur l’ensemble de la plateforme :

- JFrog Xray passe au crible l’ensemble de vos dépôts et artefacts (notamment les images Docker et les packages Maven) afin de recenser chaque modèle, package, jeu de données et dépendance associée, qu’il soit propriétaire ou open source.

- JFrog Advanced Security effectue une analyse du code source pour détecter les signatures d’appels à des API d’IA externes (par ex. OpenAI, Gemini ou Anthropic).

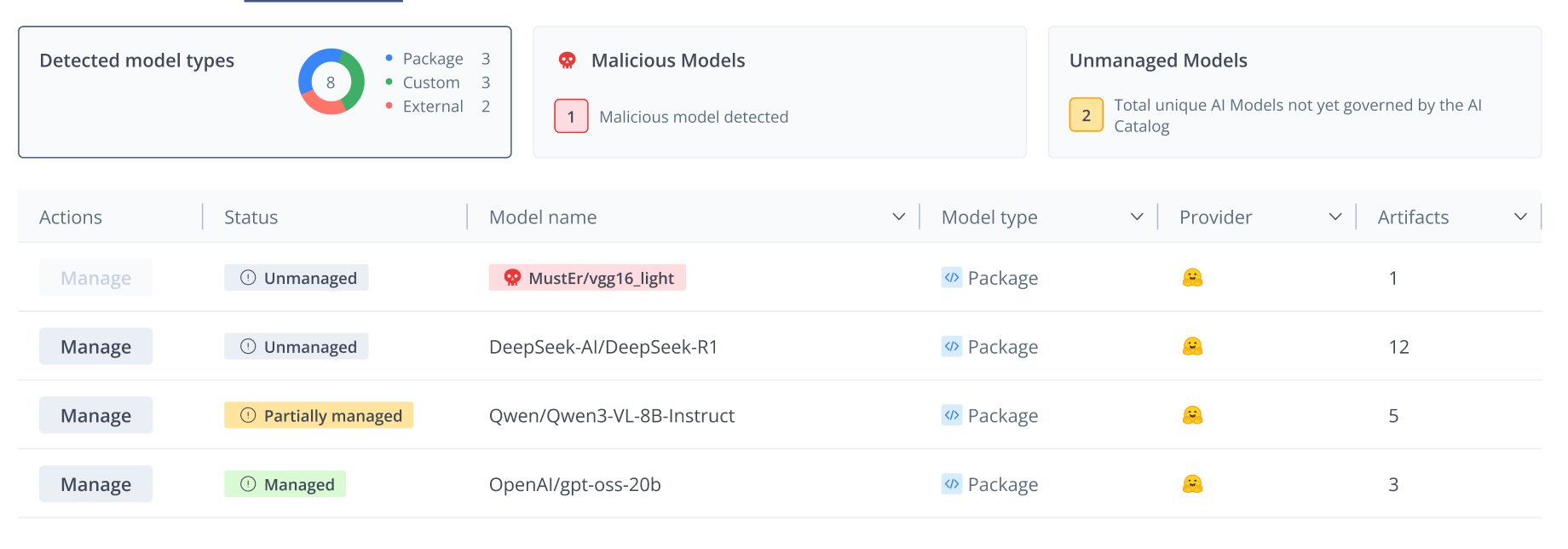

Une fois le scan terminé, le tableau de bord Detected Models dans l’AI Catalog devient votre source de vérité centralisée, affichant chaque instance d’utilisation de l’IA, gérée ou non, à travers vos dépôts et vos builds.

Étape 2 : Examiner l’inventaire « Shadow »

Une fois que vous disposez d’une visibilité exhaustive, la priorisation devient clé. Le tableau de bord Detected Models classe et catégorise automatiquement les résultats afin de vous aider à traiter en premier les actifs présentant le niveau de risque le plus élevé.

Hiérarchisez votre examen en utilisant ces trois critères :

- Les modèles malveillants d’abord : traitez toujours immédiatement les modèles signalés par Xray comme malveillants ou à haut risque. Ce sont les incendies à éteindre en priorité.

- Fréquence d’utilisation : triez les modèles en fonction de leur fréquence d’apparition dans vos builds. Une utilisation généralisée indique une forte dépendance et un risque opérationnel plus important que vous devez traiter rapidement.

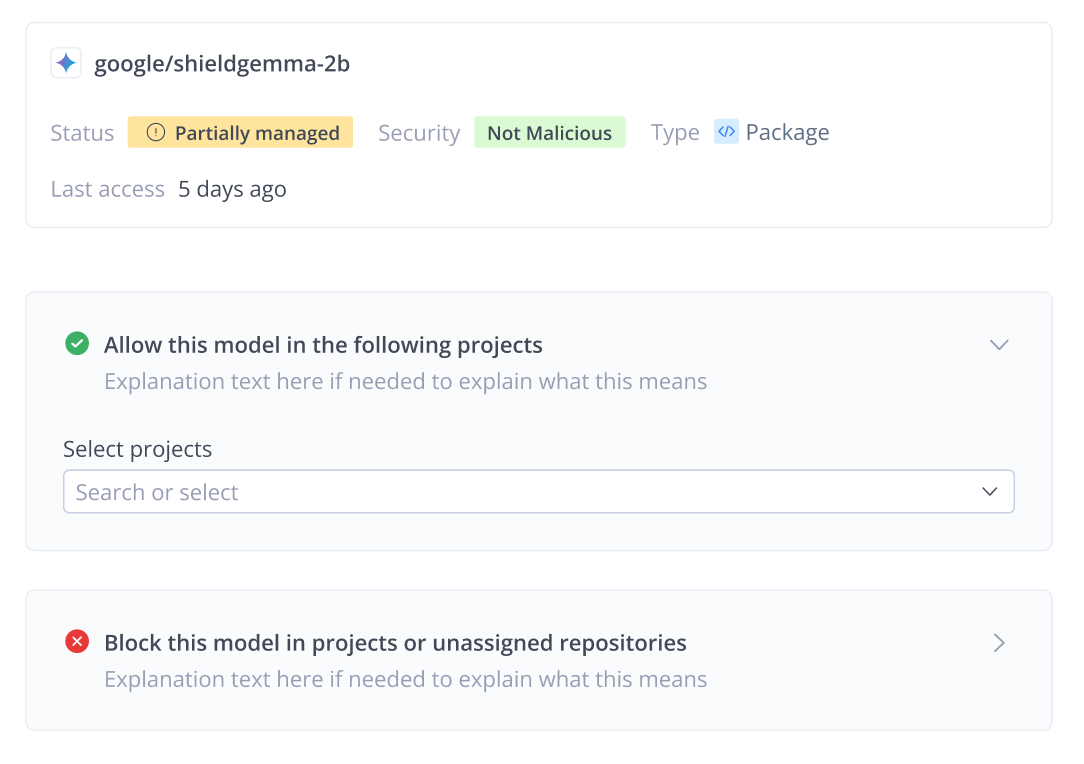

- Statut de gouvernance : le système marque les actifs comme Non géré (Unmanaged), Géré (Managed) ou Partiellement géré (Partially managed).

Cet inventaire détaillé impose un passage d’une gouvernance réactive à une gouvernance pro-active ; vous allez au-delà de la simple identification du Shadow AI pour comprendre son impact réel sur l’entreprise.

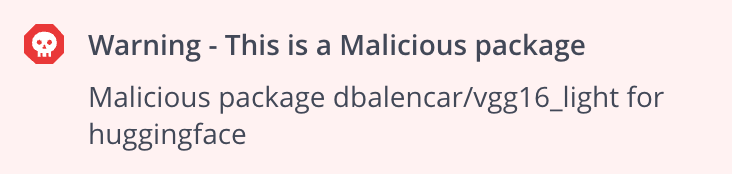

Étape 3 : Évaluer le risque

Avant de décider d’« Autoriser » ou de « Bloquer » un modèle, vous devez quantifier le risque. Cela nécessite une analyse approfondie des implications en matière de sécurité et de conformité de l’actif non géré.

1. Risque de sécurité :

Les modèles open source, en particulier ceux provenant de hubs comme Hugging Face, constituent des cibles privilégiées pour des attaques de la chaîne d’approvisionnement, telles que le détournement d’espace de noms (en anglais, namespace hijacking). Des acteurs malveillants peuvent y publier des modèles « empoisonnés » qui exécutent du code dès leur téléchargement, entraînant l’injection de shells inversés et la compromission des systèmes.

2. Risque de conformité :

Les actifs non gérés présentent également des risques juridiques majeurs. Sur le plan des licences, l’utilisation involontaire d’un modèle soumis à une licence non commerciale au sein d’un produit commercial constitue une violation du droit de la propriété intellectuelle. Par ailleurs, les appels d’API codés en dur vers des services tels qu’OpenAI exposent à un risque de fuite de données : des prompts sensibles et des données propriétaires peuvent quitter votre environnement contrôlé et être traités par des systèmes tiers.

Pour contrer ces menaces, l’AI Catalog s’appuie sur JFrog Xray et Advanced Security afin d’établir une vision claire de la sécurité et de la conformité pour chaque modèle. La plateforme analyse les artefacts contenant ces modèles afin de détecter les vulnérabilités dans les dépendances, et signale les packages malveillants ou à haut risque pour vous permettre d’agir rapidement. En parallèle, elle vérifie la conformité des licences et détecte les signatures d’API présentes dans votre code. En agrégeant l’ensemble de ces données de sécurité et juridiques dans une vue unique, vous disposez d’un registre auditable pour prendre une décision de gouvernance éclairée.

Étape 4 : Application des politiques

Une fois le risque quantifié, vous passez de l’observation passive au contrôle actif. Votre objectif est simple : vous assurer que les équipes n’utilisent que des actifs d’IA conformes et approuvés, et bloquer tout le reste.

Si un actif est à haut risque, malveillant ou enfreint une politique, vous pouvez le bloquer immédiatement.

- Bloquer depuis le cache : lorsque vous marquez un modèle comme « Bloqué », le système crée automatiquement une politique de Curation. En une seule action, il supprime toutes les instances mises en cache de ce modèle dans les dépôts distants et empêche les téléchargements futurs.

- Politique de blocage Xray : dans le cas des dépôts locaux, une politique de blocage des téléchargements Xray empêche toute utilisation du modèle au sein de projets soumis à des règles de gouvernance.

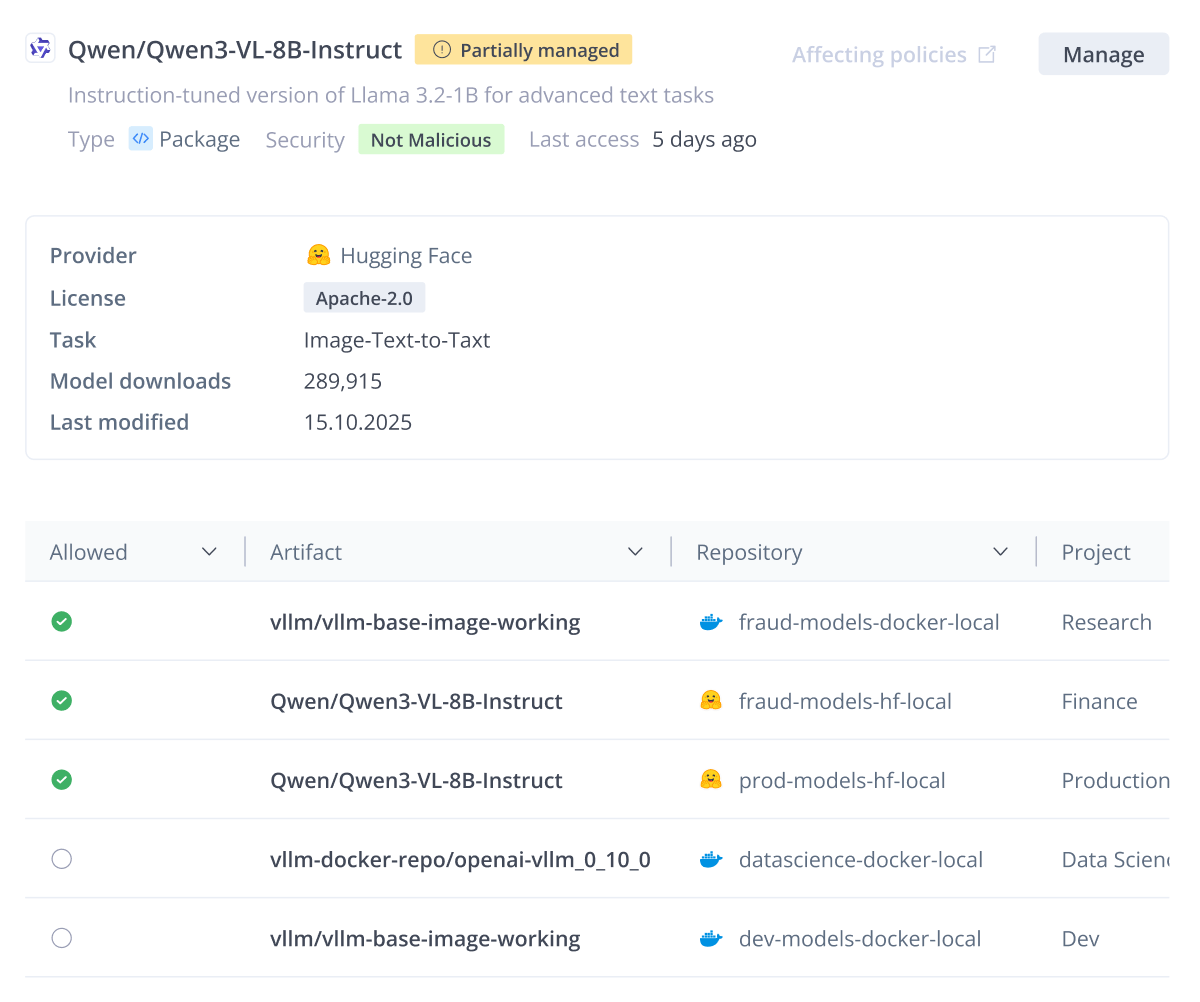

Vous rencontrerez souvent des modèles avec un statut Partially Managed. Cela indique un état d’incohérence : le modèle est autorisé dans un seul projet, mais il est toujours détecté dans les dépôts d’autres projets où une décision de gouvernance n’a pas encore été prise.

Au lieu de bloquer ces modèles et de risquer d’interrompre des workflows valides, utilisez l’action Autoriser (Allow) pour étendre la gouvernance aux instances non gérées. Cela unifie le statut du modèle, garantissant qu’il est surveillé et sécurisé de manière cohérente dans toutes les équipes qui l’utilisent.

Gérer l’utilisation existante

Certains modèles sont déjà utilisés par plusieurs équipes, ce qui rend un blocage immédiat et strict trop perturbateur. Dans ces cas, le statut Partially Managed joue un rôle clé :

- Ce statut indique que le modèle est autorisé dans un projet mais reste non géré dans un autre, souvent en raison de dépôts partagés.

La solution consiste à utiliser l’action Allow afin d’intégrer les projets non gérés restants sous la gouvernance de l’AI Catalog, garantissant une transition fluide vers un état entièrement géré, sans provoquer d’échecs inutiles pour les développeurs.

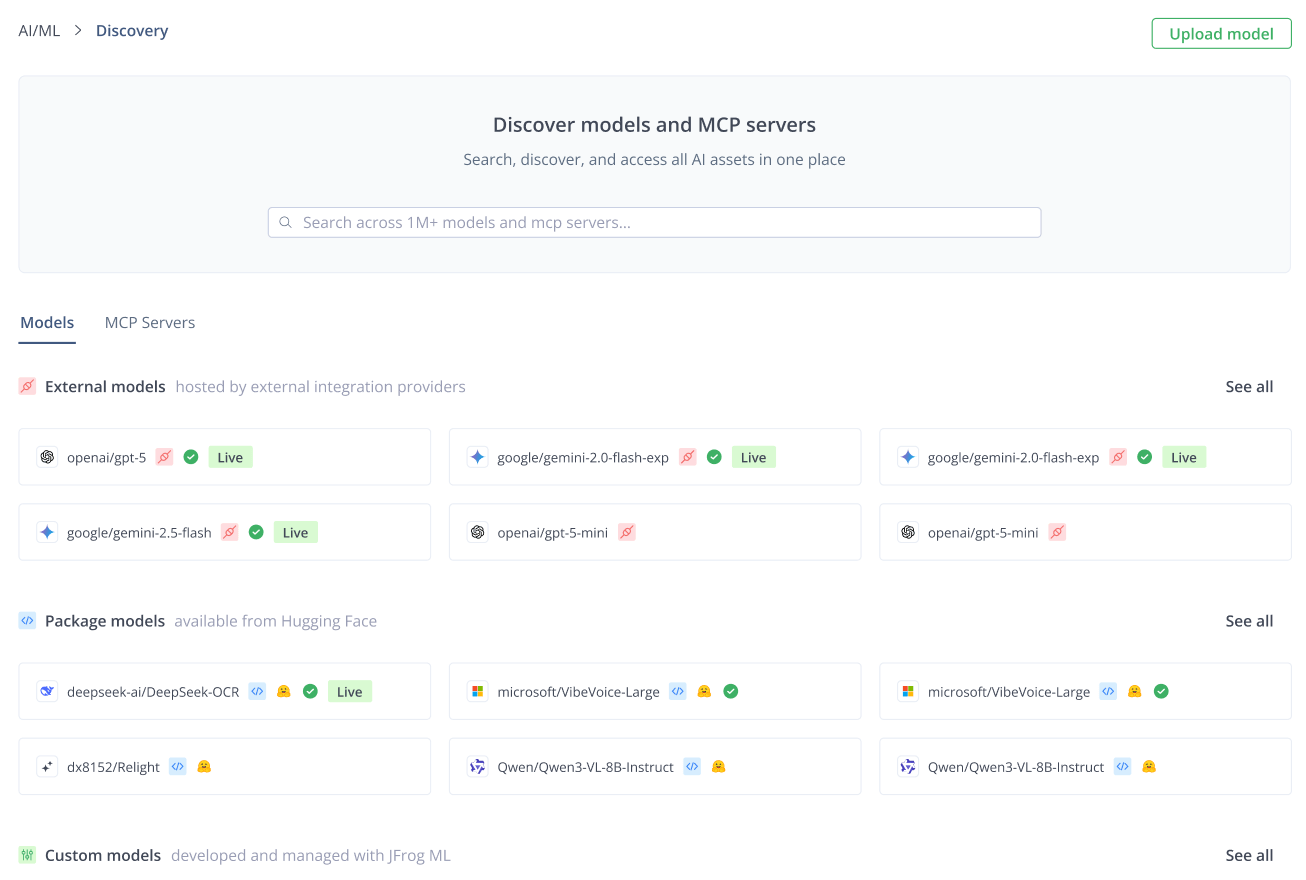

Étape 5 : Définir le parcours de référence

L’étape finale consiste à faire évoluer l’expérience développeur d’un « far west » de modèles non sanctionnés vers un parcours de référence d’innovation maîtrisée et sécurisée.

Si vous bloquez un actif d’IA, vous devez fournir une alternative de confiance. L’AI Catalog le permet en créant un hub centralisé en self-service :

- Découverte de confiance : les développeurs parcourent le registre à la recherche de services internes, open source et commerciaux approuvés. Ils savent instantanément que tout actif qu’ils choisissent est sécurisé et conforme.

- Abstraction des identifiants : l’AI Gateway élimine la complexité et les risques liés aux clés API. La gestion des identifiants est entièrement prise en charge par la plateforme, permettant aux développeurs de consommer des services gouvernés sans jamais exposer de clés API.

En érigeant votre tableau de bord de gouvernance en point de contrôle central, vous faites passer votre stratégie IA d’un chaos non maîtrisé à une vélocité fiable, ajustée au risque et digne de confiance.

Prenez le contrôle de votre IA

Dans un monde de développement à grande vitesse, le Shadow AI est une réalité incontournable — mais il ne doit pas pour autant être un risque hors de contrôle. En considérant les actifs d’IA comme des éléments à part entière de votre chaîne d’approvisionnement, vous pouvez étendre vos pratiques éprouvées de gestion des artefacts, de sécurité et de gouvernance à ce nouveau périmètre.

L’AI Catalog offre la visibilité nécessaire pour détecter chaque actif non géré et le plan de contrôle pour les gouverner, vous assurant de pouvoir adopter l’IA en toute sécurité et à grande échelle.

Prêt à éliminer le Shadow AI et à prendre le contrôle de vos workflows d’IA ? Contactez nos experts et lancez le scan dès aujourd’hui.