développement logiciel.Read Less >

Comment utiliser JFrog Artifactory avec Amazon SageMaker

Intégration de JFrog Artifactory à Amazon SageMaker

DevSecOps à l’ère du développement de modèles d’IA/ML avec AWS

JFrog et AWS accélèrent le développement sécurisé du machine learning

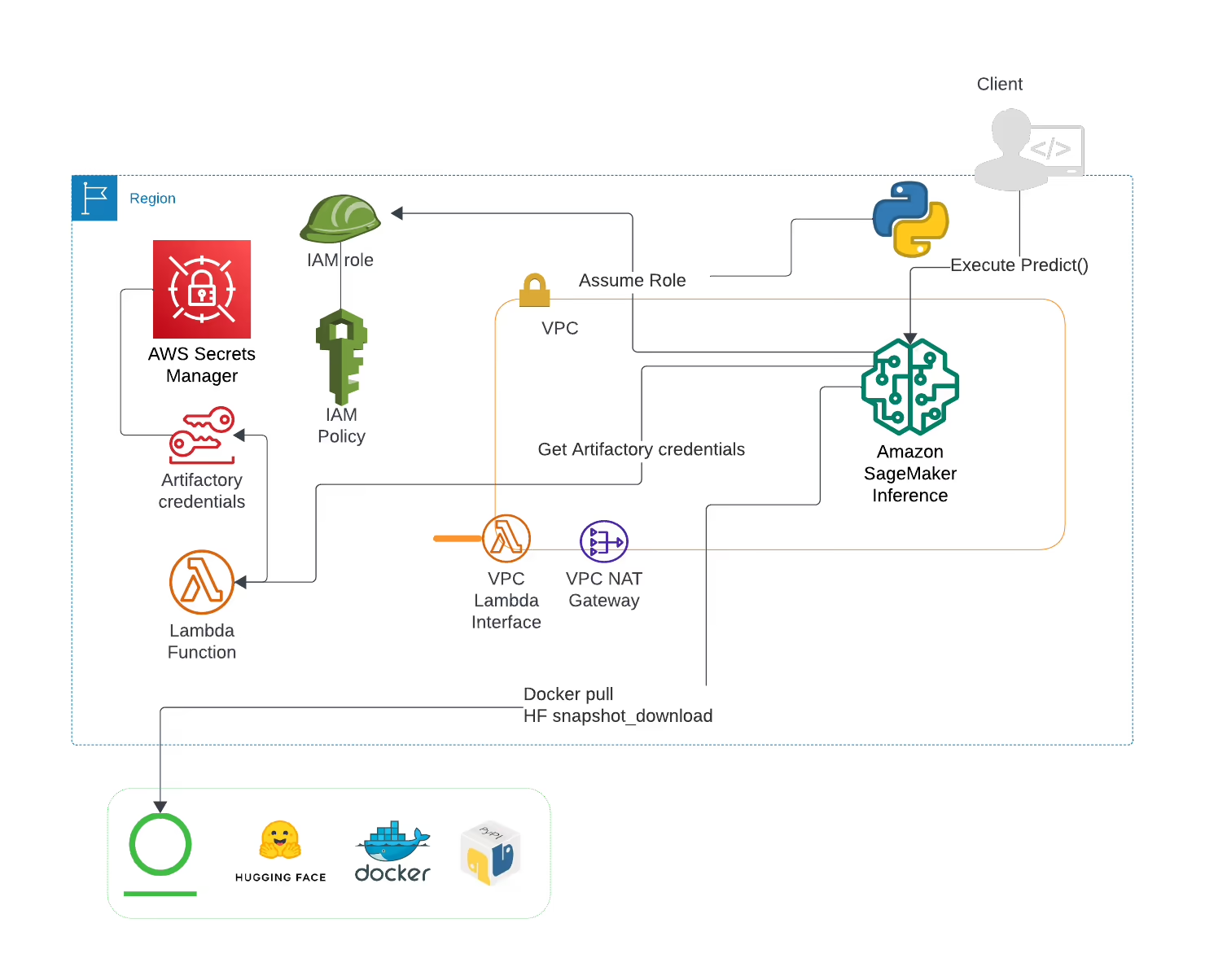

L’intégration de JFrog Artifactory à Amazon SageMaker vous permet de gérer, de versionner et de distribuer efficacement des modèles de machine learning, des ensembles de données et d’autres artefacts. Cette intégration garantit que vos workflows ML sont rationalisés, de l'entraînement au déploiement, tout en gardant le contrôle de toutes les dépendances et en permettant la collaboration entre les équipes.

Pour configurer JFrog Artifactory pour la gestion des artefacts SageMaker, vous devez configurer Artifactory pour stocker vos modèles de machine learning, vos jeux de données et vos images Docker. Ces artefacts peuvent ensuite être extraits dans SageMaker à des fins d'entraînement et de déploiement. Des instructions de configuration détaillées sont disponibles dans la documentation JFrog et AWS.

Oui, JFrog Xray peut analyser les modèles d’apprentissage automatique, les ensembles de données et les images de conteneurs stockés dans Artifactory à la recherche de vulnérabilités de sécurité et de problèmes de conformité. Cela garantit que seuls des artefacts sécurisés et conformes sont déployés dans Amazon SageMaker, ce qui renforce la sécurité de vos workflows de ML.

JFrog Artifactory fournit un contrôle de version robuste pour les modèles d’apprentissage automatique et d’autres artefacts. Chaque version d’un modèle ou d’un ensemble de données est stockée avec des métadonnées uniques, ce qui facilite le suivi des modifications, le retour aux versions précédentes et la garantie de la reproductibilité de vos flux de travail SageMaker.

JFrog Artifactory peut gérer un large éventail d’artefacts à utiliser avec Amazon SageMaker, notamment des modèles de machine learning, des ensembles de données, des blocs-notes Jupyter, des images Docker et des packages Python. Cette flexibilité vous permet de centraliser la gestion de toutes les ressources nécessaires à vos projets ML en un seul endroit.